ChatGPT爆火之后,AIGC往何处

(报告出品方/作者:国信证券,张衡、夏妍)

来源:未来智库

AI(人工智能):第四次生产力革命

AI(Artificial Intelligence):1952 年,图灵在《计算机械与智能》一文中提到了“图灵测试”来验证机器是否具有智能:如果一台机器能够与人类展开交流,并且有超过 30%的人无法在规定时间内识别出与自己交谈的是人还是机器,那么这台机器可以被认为是具有智能的。后来科技界又提出了其他界定人工智能的标准:例如能否实现语音识别、机器翻译、自动写作等等。本报告中所提及的人工智能技术,不仅包括具有自然语言处理能力、或通过图灵测试的AI 技术,还包括有海量数据、超复杂性、要求实时性、人类智能暂时无法处理的机器智能技术。

AI 发展原动力:提效降本,在新一轮技术革命中抢占先机

微观:提效降本,科技让生活更美好

从 C 端用户需求来看,人工智能解决的是与人相关的娱乐、出行、健康等生活场景中的痛点。人工智能在 C 端的应用分为两方面:1)对原有劳动力的替代与生产力效率的提升:如语音识别、智能客服、机器翻译等;2)新增需求的满足:如“千人千面”的信息分发(如抖音、快手、小红书等)、内容生成(AIGC)、人机交互(如 ChatGPT 等)、辅助驾驶、安防等。从 B 端需求来看,企业对于效率的提升需求旺盛,人工智能在金融、公共安全、医疗健康等领域均取得了较为普遍的应用。

宏观:新一轮技术革命,赢得未来国与国之间科技竞争的主动权

人工智能有望引领了蒸汽革命、电气技术革命以及信息产业革命之后的第四次生产力革命。1)18 世纪 60 年代,英国率先发展并完成了第一次工业革命,在随后的一个多世界里成为了世界霸主;2)19 世纪 60 年代,完成了资产阶级革命或改革的美、德、法、日在第二次工业革命中崛起,使人类进入“电气时代”;3)进入 20 世纪中叶,以信息技术、新能源技术的代表的第三次科技革命在美国兴起,进一步强化了美国的霸主地位。自 2006 年以来,Hinton 提出深度学习算法,令机器在自主学习方面有了革命性的突破,同时,伴随着海量数据的积累、GPU、芯片计算能力的提升,人工智能的三大要素“算法”、“算力”和“数据”皆已准备就绪。2016 年,AlphaGo 首次击败人类问鼎世界冠军,人工智能的关注度急速攀升。而近期人工智能技术在安防、金融、医疗、内容分发领域的持续落地,使AI 技术在提效降本、解放劳动力、提升资源配置效率方面的巨大作用得以显现。我们认为,在本轮变革中具有良好技术沉淀和全面布局的国家有望抢得科技的主动权。

产业链及发展历程:三起两落,数据及算力爆发带来新一轮AI 发展机遇

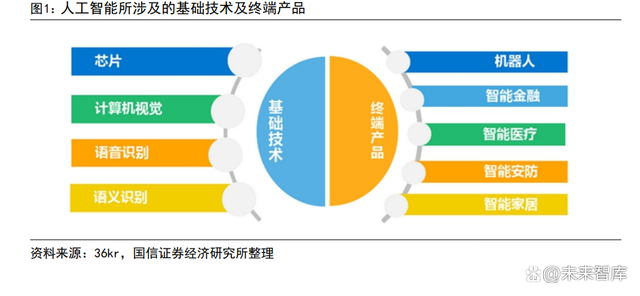

产业链:基础层+技术层+应用层

总体来看,人工智能产业链可分为基础支撑层、技术层和应用层。基础层提供算力,主要包含人工智能芯片、传感器、大数据及云计算。其中,芯片具有极高的技术门槛,且生态搭建已基本成型。目前该层级的主要布局玩家为Nvidia、AMD、英特尔等在内的国际科技巨头,国内在基础层的布局和实力均相对薄弱。技术层主要解决具体类别问题,这一层级主要依托运算平台和数据资源进行海量识别训练和机器学习建模,开发面向不同领域的应用技术,包括语音识别、自然语言处理、计算机视觉和机器学习技术等。科技巨头谷歌、IBM、亚马逊、苹果、阿里巴巴、百度都在该层级深度布局,并涌现了如商汤科技、旷世科技、科大讯飞等诸多独角兽公司。应用层主要解决场景落地问题,利用AI 技术针对行业提供产品、服务和解决方案,其核心是商业化。得益于人工智能的全球开源社区,应用层的进入门槛相对较低,但也是商业价值最大的环节(典型如算法推动在抖音、快手等应用端落地)。

发展历程:60 年三起两落,呈螺旋式发展

回顾人工智能技术的发展历程,我们发现,人工智能所经历的三次兴起浪潮均源于底层算法的革命性进展,而前两轮的衰落是由于数据处理性能及底层算法的局限,使 AI 技术从成熟度以及商业可行性上无法落地。2006 年,Hinton 提出颠覆性的深度学习算法,使得 AI 产业迈出关键性一步:利用多层神经网络,将人类从复杂的算法归纳中解放出来,只要给予机器足够多的数据,便能使其自动归纳出算法,叠加底层算力 GPU 的不断发展及互联网时代海量数据的积累,人工智三驾马车:算法、算力和数据皆已准备就绪,使 AI 技术彻底走出实验室,逐步渗透进各个行业和场景。

第一轮:兴于感知神经网络,终于计算机性能约束

兴起:1956 年达特茅斯会议开启了人工智能的元年,仅在定理层次等证明了AI商用的可能性,实际应用还十分有限。1956 年,以约翰·麦卡锡、马文·明斯基、克劳德·香农等为代表的科学家们在达特茅斯组织了一场为期两个月的人工智能夏季研讨会,探讨如何通过机器模拟人类学习或人类智能的其他特征。本次会议结束后,很多国家政府、研究机构、军方等都开始投资人工智能,掀起了第一波人工智能热潮。在第一波 AI 的浪潮中,占据主导地位的思想是逻辑主义,即通过引入符号方法进行语义处理、将待研究和解决的问题转化为可以用计算机处理的符号,运用逻辑公理进行解答,从而实现人机互动。第一波人工智能浪潮的总体成就有限,仅在定理证明等特定领域取得了成功。受制于计算机性能及可获取的数据量,当时的人工智能只能完成玩具式的简单任务,在语音、图像识别及想起游戏等看似简单的任务上,进展都十分有限。

衰落:计算机的性能制约了早期程序的应用,人工智能的发展首次预冷。受限于计算机的处理性能,当时其所能处理的程序对象少且复杂度低,机器无法读取足够的数据实现智能化,AI 自然无法大规模落地商用。1973 年,学者莱特希尔发表了一份具有影响力的评估报告《人工智能:一般性的考察》,报告指出:“迄今为止,人工智能没有在任何领域发生之前预想的重大影响,人工智能的投入是金钱的浪费”,该报告发表后,英国政府随后终止了对爱丁堡等几所高效的人工智能项目的支持。到 70 年代中期,美国和其他国家在该领域的投入也大幅度削减,人工智能发展进入寒冬。

第二轮:兴于 BP 神经网络,终于专家系统失败

兴起:1980 年代,Hopfield 神经网络和 BT 训练算法的提出,使基于AI技术的专家系统首次得以商用。Hopfield 神经网络是通过对动物或人脑的基本单元一神经元建模和连接,探索模拟动物或人脑神经系统的学习、联想、记忆和模式识别等功能的人工模型。基于该模型,IBM 等公司开发出了一系列用于模拟专家决策的专家系统,使人工智能第一次实现商业化落地。衰落:算法局限使计算结遭遇瓶颈,人工智能由于实际商用成本过高再次衰落。专家系统的维护成本极高,但神经元网络只能解决单一问题,数据量积累到一定程度后,计算结果便不再改进,实际应用价值有限。1987 年,苹果和IBM生产的台式机性能超过了由 Symbolics 等厂商生产的通用计算机,专家系统逐渐淘汰。

第三轮:兴于深度学习算法,强于数据及算力

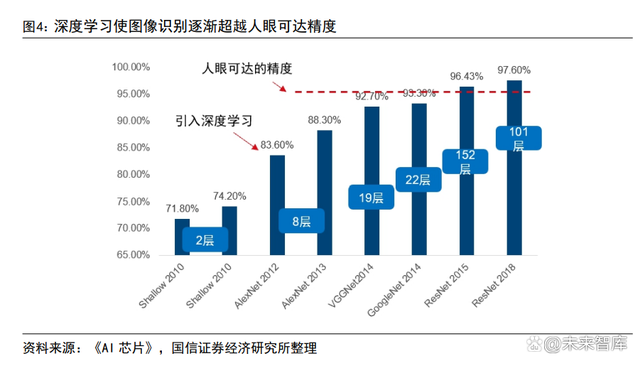

兴起: 2006 年,Hinton 提出了神经网络 DeepLearning 算法,将人类从复杂的算法归纳中解放了出来,使人工智能再一次聚焦了学术界和产业界的目光。从底层算法来讲,深度学习算法弥补了传统 BP 神经网络的缺陷:1)多隐层的人工神经网络具有优异的特征学习能力,从而有利于可视化或分类;2)传统人工神经网络的训练难度可以通过“逐层初始化”来克服。通俗来讲,本轮算法的革命性进步在于:不需要人工去提取规则特征,机器通过海量数据,即可自动实现规则的特征提取,将最复杂的“算法归纳”留给机器去完成。数据显示,自2012年在图像识别领域引入深度学习算法以来,图像识别的错误率显著降低。并通过深度学习训练层数的增长及优化,在 2015 年通过 ResNet 模型使图像识别的精度超过了人眼可达的精度。

免责声明:数字资产交易涉及重大风险,本资料不应作为投资决策依据,亦不应被解释为从事投资交易的建议。请确保充分了解所涉及的风险并谨慎投资。OKEx学院仅提供信息参考,不构成任何投资建议,用户一切投资行为与本站无关。

和全球数字资产投资者交流讨论

扫码加入OKEx社群

industry-frontier