金花235(金花235能吃什么

来源:学术头条

图片来源:由无界 AI生成

上个月,ChatGPT 正式具备了图像与语音识别能力。

本月初,微软更是公布了 166 页的多模态版 GPT-4V 的相关文档,详细探讨了 GPT-4V 的功能和使用情况,这一举动引起了业界的广泛关注。

然而,在视觉语言模型的角逐中,谷歌也不甘示弱。

近日,Google Research、Google DeepMind 和 Google Cloud 共同推出了一个更小、更快、更强大的视觉语言模型(VLM)——PaLI-3,该模型与相似的体积大 10 倍的模型相比具有显著竞争力。

研究人员使用分类目标预训练的视觉变换器(ViT)模型与对比性预训练的模型(SigLIP)进行了比较,结果发现,PaLI-3 虽然在标准图像分类基准上略微表现不佳,但基于 SigLIP 的 PaLI 在各种多模态基准测试中表现出卓越的性能,特别是在定位和文本理解方面。

相关研究论文以“PaLI-3 Vision Language Models: Smaller, Faster, Stronger”为题,已发表到预印本网站 arXiv 上。

研究团队认为,仅有 50 亿参数的 PaLI-3 重新点燃了关于复杂 VLM 核心组成部分的研究,可能推动新一代规模更大的模型的发展。

更高分辨率的多模态学习

最近,大型视觉语言模型在其更大的模型中使用预训练的图像编码器,其中一些使用监督分类进行预训练(如PaLI,PaLI-X,Flamingo,PaLM-E),一些使用预训练的CLIP编码器(如BLIPv2,CrossTVR,ChatBridge,还有一些使用自定义多模态预训练(如 BEiT3,CoCa,SimVLM)。

本次研究的训练方法包括三个主要组成部分:在网络规模的图像文本数据上进行图像编码器的对比性预训练,改进的 PaLI 多模态训练数据混合以及以更高分辨率进行训练。

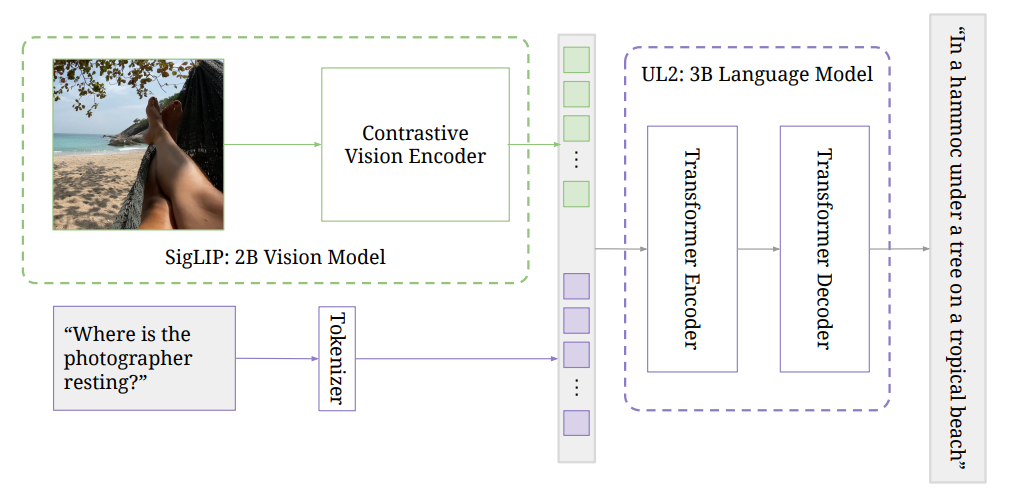

在单模态预训练阶段,图像编码器在 Web 上的图像文本配对上采用 SigLIP 训练协议进行对比预训练。研究人员采用了一种基于模型的过滤方法,保留了大约 40% 的配对。图像编码器在 224×224 的分辨率下进行训练。文本编码器-解码器是一个 3B UL2 模型,按照混合去噪程序进行训练。

在多模态训练阶段,研究人员将图像编码器与文本编码器-解码器结合在一起,形成了 PaLI 模型。这个模型针对多模态任务进行训练,保持图像编码器的冻结状态,使用原生分辨率(224×224)。

主要的数据混合来自 WebLI 数据集,经过筛选和使用特定的训练目标。其他元素包括多语言字幕、OCR 处理、跨语言 VQA 和 VQG、物体感知 VQA 以及物体检测。虽然没有包括来自视频的任务或数据,但由于强大的图像编码器,PaLI-3 在这些基准上仍然具有竞争力。此外,通过向 WebLI 添加了包含稠密文本和网络图像(如海报或文档)的 PDF 文档,以及支持 100 多种语言的文本,文档和图像理解能力得到了进一步的提高。

在提高分辨率阶段,研究通过对整个模型进行微调(解冻图像编码器)并使用逐渐增加分辨率的短期课程来提高 PaLI-3 的分辨率,保持在 812×812 和 1064×1064 分辨率处的检查点。数据混合主要集中在涉及视觉定位文本和物体检测的部分。

提升图像理解与文本定位任务

首先,研究人员在 PaLI 框架内进行了对不同的 ViT 模型的有控制的比较。结果发现,虽然 SigLIP 模型的少样本线性分类性能较差,但当在 PaLI-3 中使用时,SigLIP 模型在"简单"任务(如字幕和问答)上提供了适度的性能提升,并在更"复杂"的场景文本和空间理解任务(如 TextVQA 和 RefCOCO 变体)上提供了大幅提升。

随后,研究又在视觉定位文本理解任务中评估了 PaLI-3,这些数据集中的图像涉及自然图像、插图、文档和用户界面等各种领域。PaLI-3 在绝大多数字幕和 VQA 基准上,无论是否有外部 OCR 输入,都取得了最先进的性能。唯一的例外是 AI2D 和 ChartQA,它们不仅需要理解,还需要对图表进行强大的推理能力。对于这两个基准,PaLI-3 稍微落后于 PaLI-X。

另外,研究人员还扩展了 PaLI-3 的功能,使其能够通过语言类似的输出来预测分割遮罩。实验结果表明,对于这种类型的定位任务,对比预训练要比分类预训练更为有效。完整的 PaLI-3 模型能够在指代表达分割方面稍微优于最先进的方法。

免责声明:数字资产交易涉及重大风险,本资料不应作为投资决策依据,亦不应被解释为从事投资交易的建议。请确保充分了解所涉及的风险并谨慎投资。OKEx学院仅提供信息参考,不构成任何投资建议,用户一切投资行为与本站无关。

和全球数字资产投资者交流讨论

扫码加入OKEx社群

industry-frontier