英伟达:帝国裂缝一条条

撰文:Melissa Heikkilä

来源:麻省理工科技评论

图片来源:由无界 AI生成

一种新的工具可以让艺术家们在将作品上传到网上之前,对其艺术作品中的像素添加不可见的更改,如果这些图片被收录进了 AI 训练集,就会导致生成模型以混乱且不可预测的方式崩溃。

该工具名为“Nightshade”,旨在反击那些未经创作者许可就使用艺术家作品训练模型的人工智能公司。使用它来“毒化”这些训练数据可能会损害图像生成模型的未来迭代,例如 DALL-E、Midjourney 和 Stable Diffusion,使它们的一些输出结果变得错乱 -- 狗变成猫,汽车变成牛,等等。目前这项研究已提交给计算机安全会议 Usenix 进行同行评审。

OpenAI、Meta、Google 和 Stability AI 等人工智能公司面临着来自艺术家的一系列诉讼,这些艺术家声称他们的受版权保护的材料和个人信息在未经同意或补偿的情况下被窃取。领导了 Nightshade 创建团队的芝加哥大学教授 Ben Zhao 表示,希望它能够对不尊重艺术家版权和知识产权的行为产生强大的威慑,从而帮助将权力天平从人工智能公司向艺术家倾斜。Meta、谷歌、Stability AI 和 OpenAI 没有回应《麻省理工科技评论》的置评请求。

据悉,Zhao 的团队还开发了一款工具 Glaze,允许艺术家“掩盖”自己的个人风格,以防止被人工智能公司窃取。它的工作原理与 Nightshade 类似:以人眼看不见的微妙方式改变图像的像素,操纵机器学习模型将图像解释为与实际显示的不同的东西。

该团队打算将 Nightshade 集成到 Glaze 中,艺术家们可以选择是否使用这种可以使数据“中毒”的工具。该团队还打算将 Nightshade 开源,也就是说,任何人都可以对其进行修改并制作自己的版本。Zhao 说,使用它并制作自己版本的人越多,该工具就会变得越强大。大型人工智能模型的数据集可能包含数十亿张图像,因此模型中的有毒图像越多,该技术造成的损害就会越大。

有针对性的攻击

Nightshade 利用了生成式人工智能模型中的一个安全漏洞,该漏洞是在大量数据的基础上训练出来的 -- 在本例中,这些数据就是从互联网上搜索来的图片。Nightshade 会破坏这些图像。

想要在线上传作品但又不希望自己的图像被人工智能公司抓取的艺术家可以将其上传到 Glaze,并选择用与自己不同的艺术风格来掩盖它。然后,他们还可以选择使用 Nightshade。一旦人工智能开发人员从互联网上获取更多数据来调整现有的人工智能模型或建立新模型,这些有毒样本就会进入模型的数据集,导致模型失灵。

例如,中毒数据样本会操纵模型,使其认为帽子的图像是蛋糕,手提包的图像是烤面包机。中毒数据很难清除,因为这需要技术公司费尽心思找到并删除每个损坏的样本。

研究人员在 Stable Diffusion 的最新模型和他们自己从头开始训练的人工智能模型上测试了这种攻击。当他们向 Stable Diffusion 只输入 50 张中毒的狗的图片,然后让它自己创建狗的图片时,输出的图片开始变得奇怪 -- 四肢过多、脸部变得卡通化。而在输入 300 个中毒样本后,攻击者就能操纵 Stable Diffusion 生成看起来像猫的狗图像。

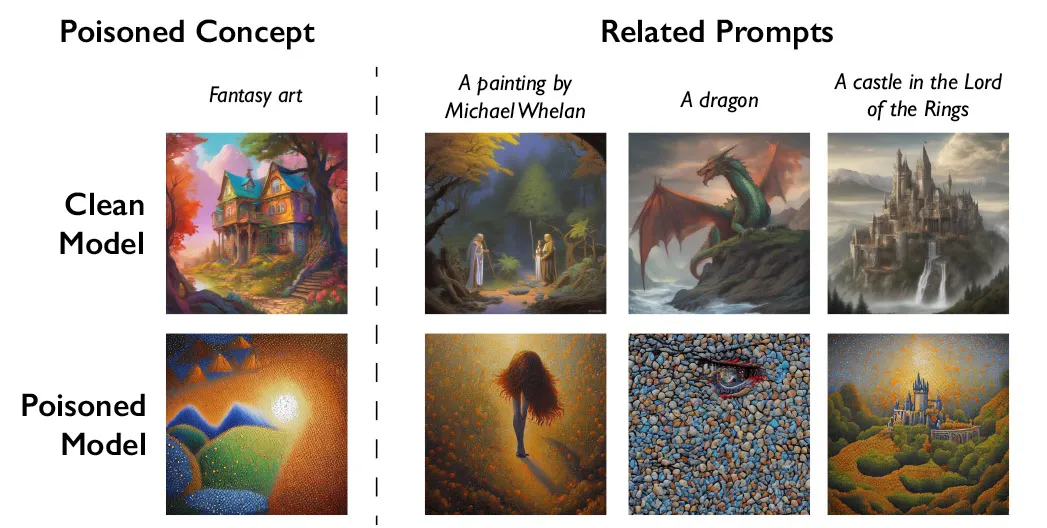

生成式人工智能模型善于在单词之间建立联系,而这也有助于毒性的扩散。Nightshade 不仅会感染“狗”这个词,还会感染所有类似的概念,如“小狗”、“哈士奇”和“狼”。这种攻击也适用于相关图像。例如,如果模型为提示“幻想艺术”抓取了一张有毒的图像,那么提示语“龙”和“魔戒中的城堡”也会类似地被操纵输出其他东西。

Zhao 承认,人们有可能滥用数据中毒技术进行恶意攻击。不过他也表示,攻击者需要数千个中毒样本才能对更大型、更强大的模型造成真正的破坏,因为这些模型是在数十亿个数据样本上训练出来的。

“我们还不知道针对这些攻击的强大防御措施。我们还没有看到过对现代 [机器学习] 模型的攻击,但这可能只是时间问题。”康奈尔大学研究人工智能模型安全性的教授 Vitaly Shmatikov 表示,他没有参与该研究。“现在是研究防御的时候了,”Shmatikov 补充道。

滑铁卢大学助理教授 Gautam Kamath 研究数据隐私和人工智能模型的鲁棒性,他也没有参与这项研究,但他表示,这项工作“非常棒”。

Kamath 表示,研究表明,漏洞“并不会因为这些新模型而神奇消失,事实上只会变得更加严重”,“当这些模型变得越来越强大,人们对它们的信任度越来越高时,情况尤其如此,因为风险只会随着时间的推移而增加。”

强大的威慑力

免责声明:数字资产交易涉及重大风险,本资料不应作为投资决策依据,亦不应被解释为从事投资交易的建议。请确保充分了解所涉及的风险并谨慎投资。OKEx学院仅提供信息参考,不构成任何投资建议,用户一切投资行为与本站无关。

和全球数字资产投资者交流讨论

扫码加入OKEx社群

industry-frontier