浅析新 L1 公链 XION:Web3

来源:Future3 Campus

伴随 AI 等领域的发展,许多行业会从底层逻辑上实现巨大变革,算力会上升到更重要的地位,与之关联的各个方面也都会引起行业的广泛探索,去中心化算力网络有其自身优势,可答复降低中心化风险,同时也能作为中心化算力的一种补足。

需求中的算力

自2009年《阿凡达》上映,以无与伦比的真实画面掀开3D电影第一役,Weta Digital 作为其背后的巨大功臣贡献了整部电影的视效渲染工作。在它新西兰的占地10000平方英尺的服务器农场里,它的计算机群每天处理高达140万个任务,每秒处理8GB的数据,即使这样也接连持续运行了超过1个月,才完成所有的渲染工作。

大规模的机器调用和成本投入,《阿凡达》成就电影史上的卓著功勋。

同年1月3日,中本聪在芬兰赫尔辛基的一个小型服务器上挖出了比特币的创世区块,并获得了50btc的出块奖励。自加密货币诞生第一天起,算力一直在行业扮演非常重要的角色。

The longest chain not only serves as proof of the sequence of events witnessed, but proof that it came from the largest pool of CPU power.

—— Bitcoin Whitepaper

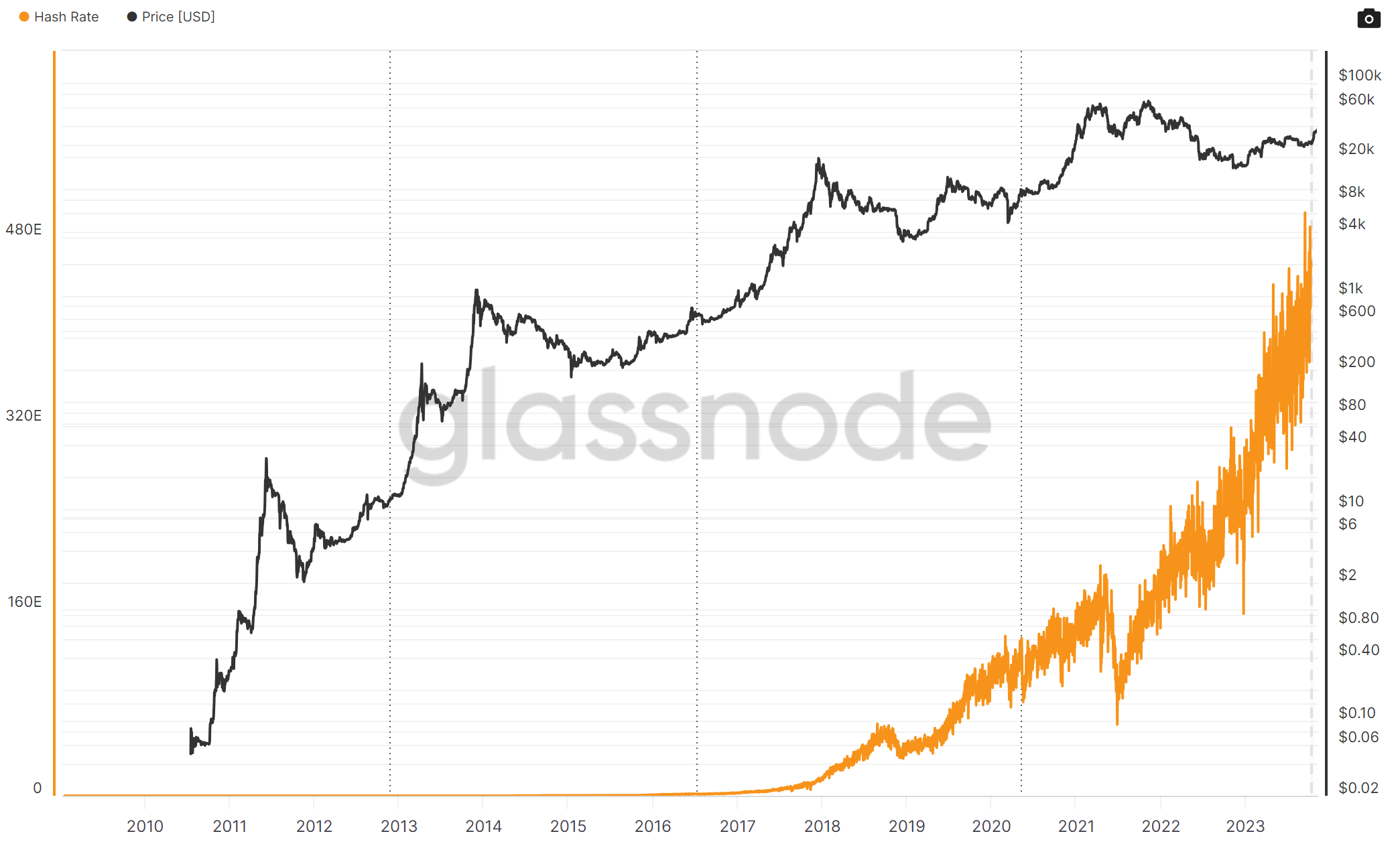

在PoW共识机制的大背景下,算力的付出为链的安全性提供保障。同时,持续走高的Hashrate 也能佐证矿工的算力上的持续投入和积极的收入预期。行业对算力的真实需求,也极大推动了芯片厂商的发展。矿机芯片经历了CPU、GPU、FPGA、ASIC等发展阶段。目前,比特币矿机通常是基于ASIC(Application Specific Ingrated Circuit)技术的芯片能高效地执行特定的算法,如SHA-256。比特币带来的巨大经济效益,也拉动着相关挖矿的算力需求一并走高,但过于专用化的设备和集群效应,使得本身参与者发生虹吸效应,无论是矿工或矿机制造商,都呈现资本密集型的集中发展趋势。

而随着以太坊的智能合约问世,随着它的可编程性、可组合性等特点,形成了广泛的应用,特别是在 DeFi 领域的运用,使得ETH的价格一路看涨,而还处于 PoW 共识阶段的以太坊其挖矿难度也一路走高。矿工对以太坊矿机的算力要求也与日俱增,但以太坊与比特币使用ASIC芯片不同,则需要使用图形处理器(GPU)来进行挖矿计算,如Nvidia RTX系列等。这样它更适合通用计算硬件来参与,这甚至一度引发了,市场对于GPU的争抢而导致市面上高端的显卡一度断货的局面。

而当时间来到2022年11月30日,由 OpenAI 研发的 ChatGPT 同样是展示了 AI 领域划时代的意义,用户惊叹于 ChatGPT 带来的全新体验,能如同真人一般,基于上下文完成用户提出的各种要求。而在今年9月推出的新版本中,加入了语音、图像等多模态特征的生成式AI又将用户体验带到了更新的阶段。

但与之对应的是GPT4有超过万亿级的参数参与模型预训练以及后续微调。这是 AI 领域对算力需求最大的两个部分。在预训练阶段,通过学习大量的文本来掌握语言模式、语法和关联上下文。使其能够理解语言规律,从而根据输入生成连贯且上下文相关的文本。预训练之后,再对GPT4进行微调,以便于更好地适应特定类型的内容或风格,提升特定需求场景的性能和专业化。

由于 GPT 采用的 Transformer 架构,引入自注意力机制(Self-attention),这种机制使得模型能在处理输入的序列时,同时关注序列中不同部分之间的关系,因而对算力需求急剧增长,特别是在处理长序列是需要大量并行计算和存储大量注意力分数,因而也需要大量的内存和高速的数据传输能力。目前主流的同架构LLM对于高性能GPU的需求巨大,这也表明AI大模型领域投入成本巨大。根据相关 SemiAnalysis 的推测估计GPT4一次模型训练成本高达6300万美金。而为实现良好的交互体验,GPT4 在日常运营中亦需要投入大量的算力来维持其日常运营。

算力硬件分类

这里我们要来理解一下目前主要的算力硬件类型,CPU、GPU、FPGA、ASIC 分别能处理怎样算力需求场景。

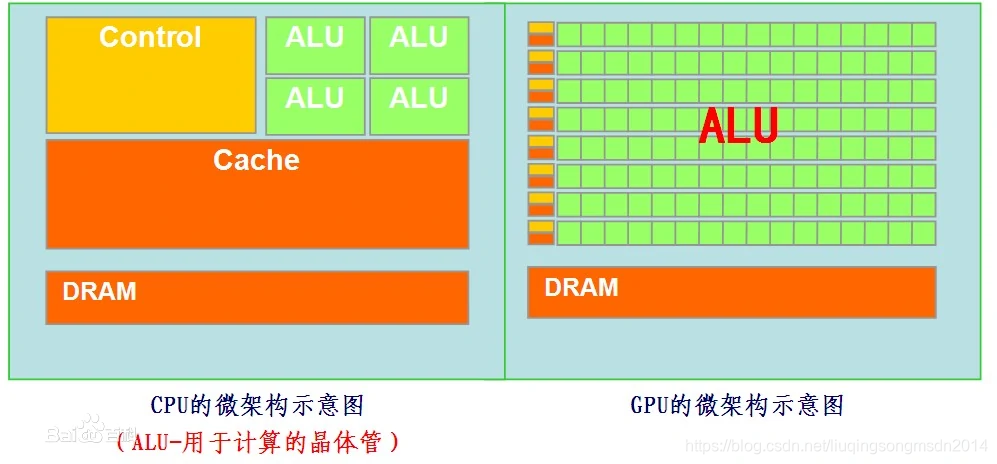

• 从CPU和GPU的架构示意图上,GPU包含更多核心,它们使得GPU可同时处理多个计算任务,并行计算的处理能力更强,适用于处理大量计算任务,因此在机器学习和深度学习领域得到了广泛的应用。而CPU的核心数量较少,适合处理更集中地处理单个复杂计算或序列任务,但在处理并行计算任务时不如GPU高效。在渲染任务和神经网络计算任务中,通常需要处理大量重复计算和并行计算,因此GPU比CPU在这个方面会更高效且适用。

• FPGA(Field Programmable Gate Array)现场可编程逻辑门阵列,是作为专用集成电路(ASIC)领域中的一种半定制电路。由大量小型处理单元组成的阵列,FPGA可以理解为可编程的数字逻辑电路集成芯片。目前的运用主要集中在硬件加速,其他任务仍然在CPU上完成,让FPGA和CPU协同工作。

• ASIC(Application Specific Integrated Circuit)专用集成电路,是指应特定用户要求和特定电子系统的需要而设计的集成电路。ASIC在批量生产时与通用集成电路相比具有体积更小、功耗更低、可靠性提高、性能提高、保密性增强、成本降低等优点。因而在比特币挖矿的固有场景下,只需要执行特定的计算任务,ASIC则是最契合的。Google 也推出了针对机器学习专门设计的 TPU(Tensor Processing Unit)作为ASIC的一种,但目前主要通过Google Cloud提供算力租用服务。

• ASIC 和 FPGA 相比,ASIC 是专用集成电路,一旦设计完成后集成电路即固定。而FPGA是在阵列内集成大量数字电路基本门电路和存储器,开发人员可以通过烧写FPGA配置来定义电路,并且这种烧写是可更换的。但就当下的AI领域的更新速度,定制化或半定制化的芯片,无法及时通过调整重新配置来执行不同的任务或适应新算法。因而,GPU 的普遍的适应性和灵活性,使其在 AI 领域大放异彩。各大 GPU 厂商就 AI 领域也对 GPU 在 AI 领域的适配做了相关优化。以 Nvidia 为例,推出了专为深度学习设计的 Tesla 系列和 Ampere 架构 GPU,这些硬件包含针对机器学习和深度学习计算优化的硬件单元(Tensor Cores),这使得GPU能够以更高的效率和更低的能耗执行神经网络的前向和反向传播。此外也提供了广泛的工具和库来支持AI开发,如 CUDA(Compute Unified Device Architecture)来帮助开发人员利用GPU进行通用并行计算。

免责声明:数字资产交易涉及重大风险,本资料不应作为投资决策依据,亦不应被解释为从事投资交易的建议。请确保充分了解所涉及的风险并谨慎投资。OKEx学院仅提供信息参考,不构成任何投资建议,用户一切投资行为与本站无关。

和全球数字资产投资者交流讨论

扫码加入OKEx社群

industry-frontier