Arbitrum网络上Uniswap日交易

文章来源:硅星人pro

图片来源:由无界 AI生成

2017年的时候谷歌发表了一篇论文,标题是《Attention Is All You Need》,翻译成中文是“你需要的只是关注”。隐藏在这个看似不明所以的标题下的,是造就了ChatGPT、Gemini等多种大语言模型的transformer模型。论文里提出了划时代的“自注意力”机制(Self-Attention Mechanism),允许模型在处理一个元素(如一个词)时,同时考虑序列中的其他元素,从而更好地理解上下文,这个机制通过计算每个元素对其他元素的“注意力分数”来实现。

与此同时,transformer模型也有比较明显的缺点:transformer模型的自注意力机制在处理长序列时具有二次方的时间和空间复杂度。这意味着随着输入序列长度的增加,所需的计算资源和时间成指数级增长。而且由于其大量的参数和复杂的层间交互,transformer模型在训练和推理时还需要大量的内存。transformer比传统的递归神经网络(RNN)在处理长距离依赖方面更有效,但在非常长的序列中处理长期依赖关系仍然是一个挑战。

那怎么办呢?transformer这么厉害的模型,放在那里不用,岂不是暴殄天物吗?于是开发者们就想尽办法,就像transformer的另一个翻译“变形金刚”一样,开发者们调整transformer模型,衍生出了多个变体,以提高最终的性能。比如刚才说的ChatGPT,就是transformer的变体——生成式预训练变压器(generative pre-trained transformer),还有谷歌的BERT(bidirectional encoder representations from transformers)等等。

华为在2023年的末尾也发表了他们的“变形金刚”——盘古π。该算法旨在通过增强快捷方式来解决Transformer架构中的特征塌陷问题,提高模型处理视觉特征的多样性和效率。算法采用并行的增强快捷连接和参数化的投影,以丰富特征表示和提高特征多样性。算法通过线性投影和非线性激活函数的组合,处理每个令牌并保留其特异性,同时与MSA模块的功能互补。

从原理上来解释,盘古π其实有两部分组成。第一部分是论文提出的一种序列信息激活函数,以增强MLP(多层感知器)模块的非线性。第二部分是,增强快捷方式以改进Transformer架构中的多头自注意力(MSA)模块。将这两个部分组合以后就是盘古π了。

逐一来展开一哈,看看这个合体金刚到底是什么来头。激活函数这个概念不稀奇,很早就有了,它在神经网络的每个节点中都有应用,以引入非线性变换。激活函数的作用是决定神经元是否应该被激活,即输出信号的强度。它们对输入信号进行一定的数学处理,然后输出到网络的下一层。就跟生物神经信号差不多,有个知名度很高的医学实验,就是用电去刺激蛤蟆的腿,这会导致蛤蟆坐立起身,原理就来自于生物神经信号一层一层的激活传递。

蛙腿实验

可是激活函数本来是非可学习的,盘古π论文中则提出了一种技术,定义可学习的激活函数ϕi,并将其应用于MLP的所有隐藏层。那么结果就是改进神经网络的非线性可以通过增加非线性激活层的数量或增强每个激活层的非线性来实现。直白点说就是更聪明了。

接着来说第二部分,纯粹的注意力机制可能遭受特征塌陷问题。典型的大型语言模型(LLM)架构为每个多头自注意力(MSA)模块只配备了一个简单的快捷连接,即身份投影,直接将输入特征复制到输出。这种简单的公式可能无法最大化地提升特征多样性。

盘古π则是提供更多绕过注意力机制的替代路径。论文用不同于直接复制输入token到对应输出的身份投影,参数化投影将输入特征转换到另一个特征空间。只要它们的权重矩阵不同,投影就会对输入特征应用不同的转换,因此并行更多增强快捷方式有潜力丰富特征空间。算法采用并行的增强快捷连接和参数化的投影,以丰富特征表示和提高特征多样性。旨在通过增强快捷方式来解决Transformer架构中的特征塌陷问题,提高模型处理视觉特征的多样性和效率。

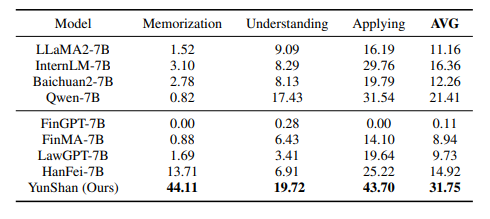

将盘古π与最先进的LLMs进行比较。结果表明,盘古π在70亿参数这个量级可以实现与基准相当的性能,推理速度提升约10%,而盘古π在10亿参数这个量级的准确性和效率方面可以实现最先进的性能。此外,根据华为实验室的说法,盘古π已经在金融和法律等高价值领域部署了70亿参数级别的盘古π,开发了名为云山的LLM进行实际应用。论文显示,云山可以在基准测试上超越其他类似规模的模型。

云山和其他模型的性能比较

免责声明:数字资产交易涉及重大风险,本资料不应作为投资决策依据,亦不应被解释为从事投资交易的建议。请确保充分了解所涉及的风险并谨慎投资。OKEx学院仅提供信息参考,不构成任何投资建议,用户一切投资行为与本站无关。

和全球数字资产投资者交流讨论

扫码加入OKEx社群

industry-frontier