盘点由Binance Labs支持且已

原文来源:新智元

图片来源:由无界 AI生成

爆火社区的Mixtral 8x7B模型,今天终于放出了arXiv论文!所有模型细节全部公开了。

还记得一个月前,Mistral AI突然公布的一条磁力链接,引爆了整个AI社区。

紧接着,Mixtral 8x7B的技术细节随之公布,其表现不仅优于Llama 2 70B,而且推理速度提高了整整6倍。

甚至,它在大多数标准基准测试上与GPT-3.5打平,甚至略胜一筹。

今天,这家法国初创正式发布了Mixtral 8x7B混合专家模型(Mixtral of Experts)的论文。

论文地址:https://arxiv.org/abs/2401.04088

网友纷纷表示,最好的开源模型论文终于发布了。

具体技术细节,我们一探究竟。

架构

Mixtral是一个稀疏的混合专家网络,而且是一个纯解码器模型。其中前馈块从一组8个不同的参数组中进行选择。

在每一层,对于每个token,路由网络都会选择其中的两个组「专家」来处理token,并将它们的输出相加。

这项技术不仅增加了模型的参数数量,而且控制了成本和延迟,因为模型每处理一个token只会使用部分参数。

具体来说,Mixtral使用32000个token的上下文信息时进行了预训练。在多项基准测试中,它的性能达到或超过Llama 2 70B和GPT-3.5。

尤其,Mixtral在数学、代码生成和多语言理解任务方面,表现卓越,并在这些领域显着优于Llama 2 70B。

而且研究表明,Mixtral能够成功地从32k token的上下文窗口中检索信息,无论序列长度和信息在序列中的位置如何。

架构细节

Mixtra基于Transformer架构打造,并使用了「Mistral 7B」论文中一些模型修改方法。

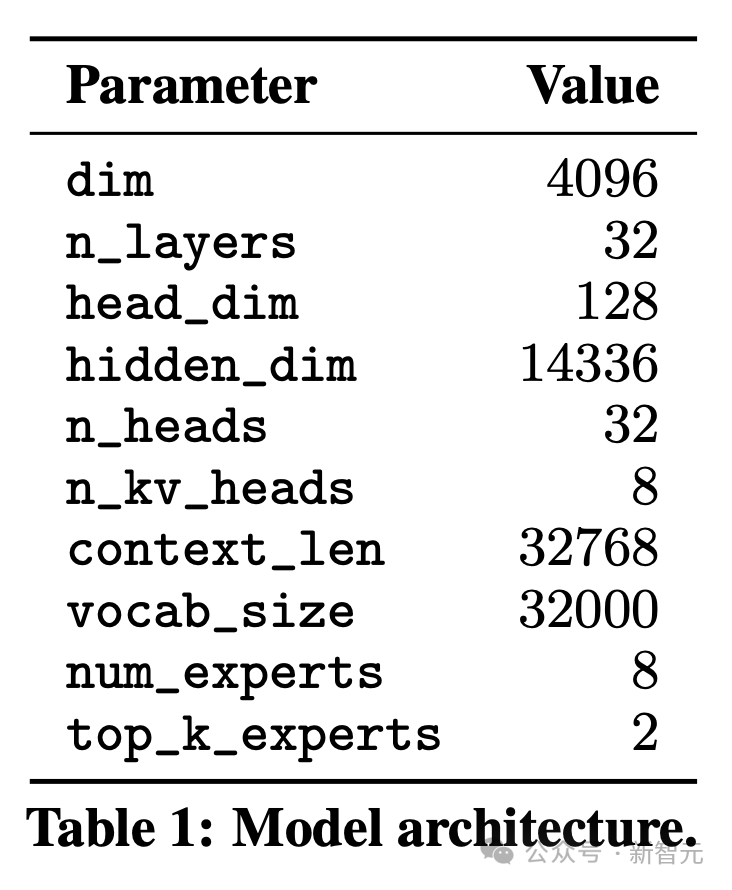

但明显不同的是,Mixtral完全支持32k token的全密集上下文长度,并且前馈块被混合专家层(Mixture-of-Expert layer)所取代。先看如下表1,汇总了模型架构的具体参数。

稀疏混合专家

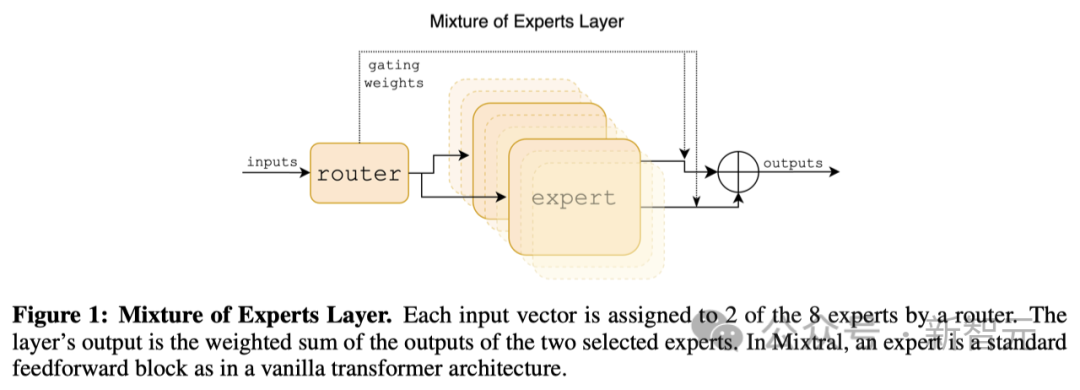

下图所示,研究人员具体介绍了混合专家层。

这是一个处理输入数据的特殊层,在这里,每个输入数据点都会被分配给8个处理单元(称为「专家」)中的2个。

这个分配过程是由一个路由完成的,但这里的路由并不是我们通常说的网络设备,而是神经网络中的一个组件,它负责决定哪些「专家」来处理特定的数据点。

每个「专家」实际上是一个处理模块,它们各自独立处理被分配的数据,并输出结果。

最终,这层的输出结果是由这2个被选中的「专家」的输出经过特定的加权计算后得到的。

在Mixtral这个系统中,每个「专家」其实就是一个标准的前馈网络模块,这种模块也被用在了我们所说的标准Transformer模型架构中。

混合专家层(Mixture of Experts Layer)

MoE层可以在具有高性能专用内核的单个GPU上高效运行。

比如Megablocks将MoE层的前馈网络(FFN)操作转换为大型稀疏矩阵乘法,显着提高了执行速度,并自然地处理不同专家获得分配它们的可变数量token的情况。

此外,MoE层可以通过标准模型并行技术以及一种称为专家并行(EP)的特殊分区策略分布到多个GPU。

在MoE层执行期间,本应由特定专家处理的token将被路由到相应的GPU进行处理,并且专家的输出将返回到原始token位置。

结果

研究人员对Mixtral和Llama进行了对比研究,为了确保比较的公正性,并重新运行了所有的基准测试,这一次采用了内部开发的评估流程。

研究人员在多种不同的任务上进行了性能评估,这些任务可以分为以下几类:

- 常识推理(零样本):包括Hellaswag,Winogrande,PIQA,SIQA,OpenbookQA,ARC-Easy,ARC-Challenge,以及CommonsenseQA

- 世界知识(少样本,5个样本):涵盖了NaturalQuestions和TriviaQA

- 阅读理解(零样本):BoolQ和QuAC

- 数学:GSM8K(少样本,8个样本)使用了多数投票法(maj@8),以及MATH(少样本,4个样本)同样采用了多数投票法(maj@4)

- 编程代码:Humaneval(零样本)和MBPP(少样本,3个样本)

- 综合性测试:MMLU(少样本,5个样本),BBH(少样本,3个样本),还有AGI Eval(少样本,3至5个样本,仅限英语选择题)

免责声明:数字资产交易涉及重大风险,本资料不应作为投资决策依据,亦不应被解释为从事投资交易的建议。请确保充分了解所涉及的风险并谨慎投资。OKEx学院仅提供信息参考,不构成任何投资建议,用户一切投资行为与本站无关。

和全球数字资产投资者交流讨论

扫码加入OKEx社群

industry-frontier