天眼深度丨2023年dApp行业增

「文生图」再升级!学习个性化参照,无限生成多样图片,轻松设计玩具建筑

文章来源:新智元

将图片集反演到语义空间的分布,生成多样个性化图片或3D渲染,支持灵活文本编辑、多样性控制、概念混合等。

图片来源:由无界 AI生成

最近,来自南加州大学、哈佛大学等机构的研究团队提出了一种全新的基于提示学习的方法——DreamDistribution。

这种方法可以让任何基于文字提示的生成模型(比如文生图、文生3D等),通过一组参照图片来学习对应的视觉属性共性和变化的文本提示分布。

论文地址:https://arxiv.org/abs/2312.14216项目主页:https://briannlongzhao.github.io/DreamDistribution/代码链接:https://github.com/briannlongzhao/DreamDistribution

不仅如此,学习到的提示分布可以用来生成近似于参照图片但更具多样性的图片,同时也支持调整分布的方差来控制多样性,结合多个提示分布生成混合概念图片等操作。

简单来说就是,仅用几张到十几张参照图片就能无限生成符合参照图片视觉效果并具有显著多样性的图片,轻松生成高达玩具模型多样新设计!

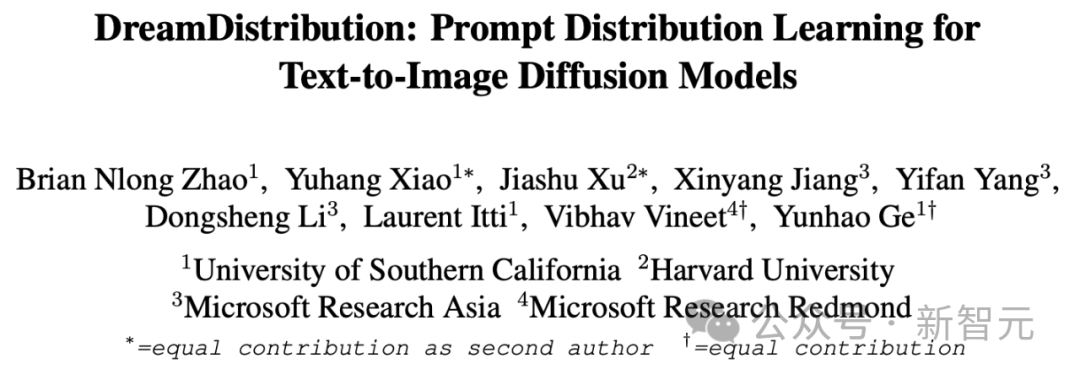

在3D生成模型上即插即用,还可以生成不同样式的跑车,建筑等:

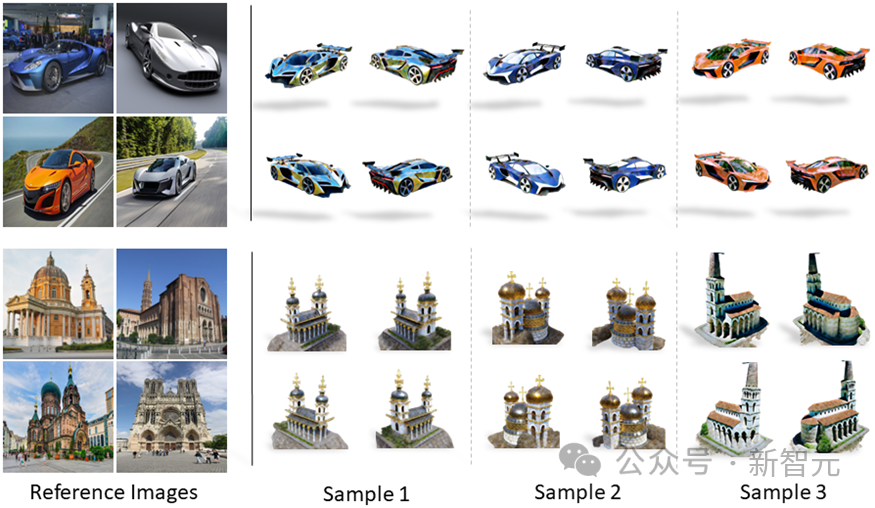

同样支持类似于Textual Inversion,DreamBooth的文本引导编辑能力:

在3D生成上同样具有编辑能力:

在训练后支持控制生成的多样性的操作(第二行向下多样性增加):

支持多种概念的混合:

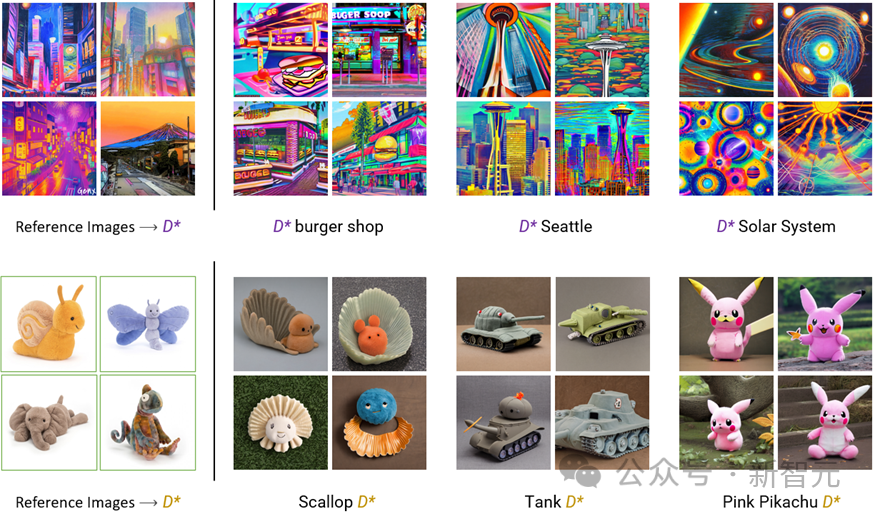

如下图所示,用户只需提供一组参照图片,比如不同的高达玩具图像,DreamDistribution就可以学习到一个对应于这一组图片的文本提示分布D*。

然后,在推理时通过从D*中采样,生成有足够变化和多样性的分布内输出图像。

此外,D*同样支持由文本引导的编辑来生成图像的变化,比如从Jumping D*的提示分布中采样即可生成跳跃姿势的高达玩具图片等等。

由于方法相对独立于下游的生成模型,学习到的提示分布同样适用于其他基于文本提示的生成任务。

除了展示中基于MVDream文本到3D生成作为例子,通过类似的提示修改也可生成具有适当变化的符合文本提示的3D模型渲染。

研究动机

在扩散生成模型日益蓬勃发展的今天,视觉生成的质量随之提高。

最先进的图片生成模型,如DALL·E,Imagen,Stable Diffusion,MidJourney等系列的文本生成图像模型,已经可以生成非常高质量的图片。

但同时,由于文本提示很难概括视觉概念上的细节,一些研究如Textual Inversion,DreamBooth等通过图片引导的方法追求模型生成的可控性以及个性化(personalization/customization)能力,即根据参照图片使生成模型理解一个个性化概念,如特定的一条宠物狗,一个特定的玩具,等等,再通过文字引导的提示编辑来生成基于个性化概念变化的图片。

然而,这些方法都着重于个性化一个具体的实例,但在很多情况下用户可能需要个性化一个更抽象的视觉特征并生成新的实例,比如生成设计风格一致的新高达玩具,或者相似画风的新卡通角色、新画作、等等。