这次Pi币真的上线主网了!

文章来源:远川科技评论

作者:叶子凌

图片来源:由无界AI生成

图片来源:由无界AI生成

前几天,英伟达成为首家市值达到2万亿美金的芯片公司,创造了历史。同一时间,一家名为Groq的初创公司横空出世,扬言“三年之内赶超英伟达”。

Groq狠话的底气,来源于它所开发的芯片——LPU。

LPU的全称是Language Processing Unit,翻译过来就是语言处理单元,是一种新型AI加速器。在它的支持下,大模型的推理速度快得惊人,瞬间能输出长篇幅答案;而使用了英伟达芯片的GPT-4,只能一个字一个字往外蹦。

前者的响应速度最高可达到500T/S,而后者只有40T/S[1]。

这是什么概念?相当于一秒钟生成300个单词,7分钟生成一部《哈姆雷特》长度级的文章。

Groq背后的团队也可谓群星璀璨,公司CEO Jonathan Ross是谷歌初代TPU的设计者之一。早期谷歌TPU团队的10位成员中,8位都跳槽到了Groq。

自2016年成立,Groq就饱受市场关注。2020年,Groq的芯片被美国阿贡实验室采用。2021年,Groq获老虎环球基金等机构投资,估值超过10亿美元。

然而,Groq公司的各种“挑衅”,英伟达完全没放在眼里。相比之下,此前“奥特曼7万亿美元造芯”的新闻出来之后,黄仁勋至少还出来说了两句。

毕竟,眼下Groq的种种套路,老黄可再熟悉不过了。

当下,制约AI芯片发展的主要困境,是内存墙:内存的传输速度远远慢于处理器算力,导致性能迟迟上不去。

如果把芯片想象成一个餐厅,那么内存就是仓库,处理器就是后厨。

仓库送菜比后厨烹饪还慢,严重限制了餐厅的出菜速度。因此,包括英伟达在内的芯片厂商,都在围绕“仓库(内存)”做文章。而Groq碾压英伟达的秘诀,也藏在内存结构里。

传统计算机所使用的内存,其实有两种:

DRAM容量较大,但传输速度较慢,起主存作用;而SRAM容量较小,但传输速度极快,作为缓存发挥辅助作用。一直以来,二者都是合作关系,缺一不可。

但Groq为了追求极致的速度,摒弃了DRAM,让SRAM扛起了LPU主存大旗。

相当于砍掉距离厨房较远的大仓库,直接将所有食材都堆在厨房边的菜篮子里。这样的设计思路下,LPU不但在速度上形成降维打击,还轻松绕过了两个成本最高的技术:HBM和先进封装。

这也构成了Groq另一个大吹特吹的宣传核心:便宜。

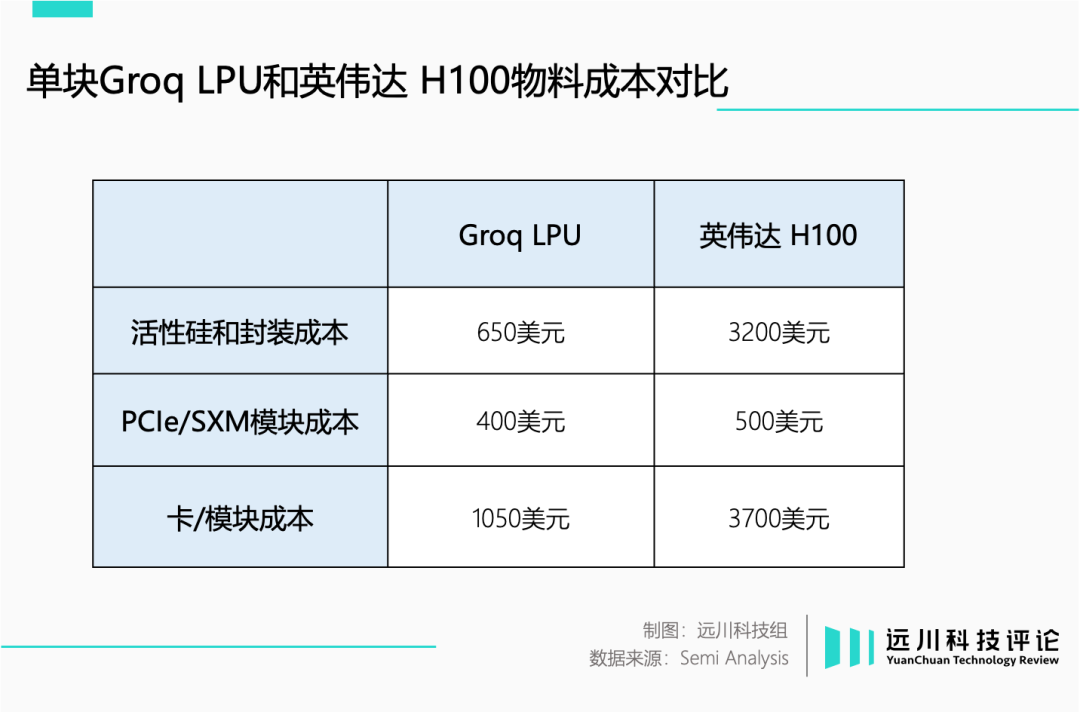

根据Semi Analysis的拆解,LPU由于具备架构优势,物料成本仅为1050美元。相比之下,去年全球疯狂的H100芯片,物料成本则达到3700美元[2]。

在售价层面,一块LPU的价格是20000美元,远低于H100的35000美元。

但历史无数次告诉我们,大部分弯道超车的结局都是有田下山,LPU也不例外。

大模型对内存大小也有着很高的要求。参数量越大的模型,运行时所需要存储的数据也会更多。

SRAM虽然快,但缺陷是容量小,通常只有4-16MB。Groq研发团队多年苦心钻研,最终也只是将LPU的容量提升至230MB。而一块H100的内存容量是80GB,两者间差了约356倍。菜篮子再怎么升级换代,终究无法和仓库相提并论。

想装下所有的食材,唯一的办法就是把菜篮子数量堆上去。因此,在运行同样参数的模型时,需要用到的LPU数量就远远高于GPU。

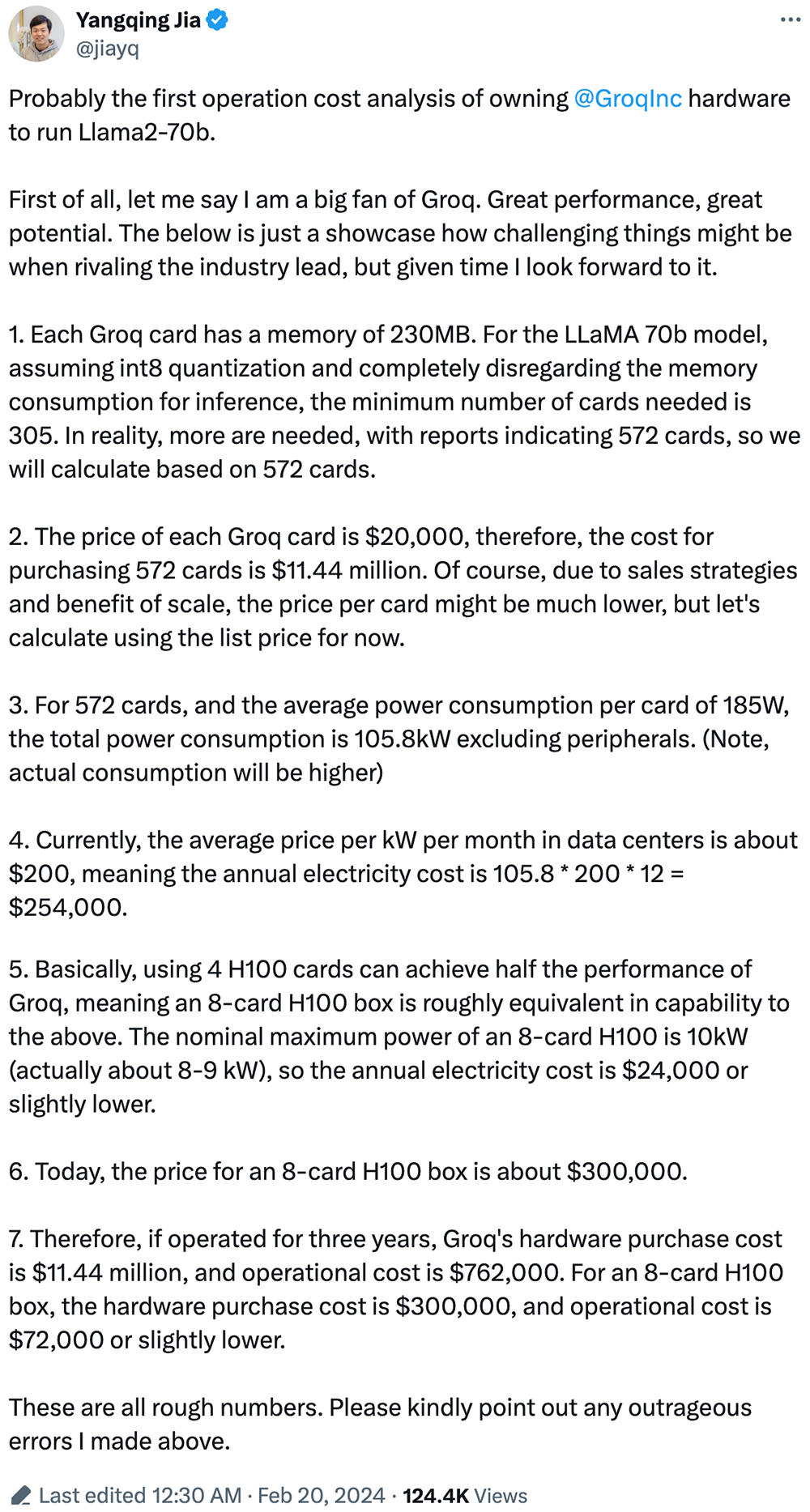

前阿里技术副总裁贾扬清就算了一笔账:

以运行LLaMA 70b模型为例,需要572张LPU,售价1144万美元;但如果换成H100,其实只需要8张,总价格在30万美元左右——所谓的“便宜”压根不成立。

芯片一多,整体的功耗成本也直线上升。LPU每年至少消耗25.4万美元电费,而H100顶多花费2.4万美元。

事实证明,Groq的遥遥领先,只是隐去了核心信息的文字游戏。它所宣传的“高速”,是以近乎夸张的使用成本换来的:运行三年LLaMA 70b模型,LPU的使用成本将比英伟达的GPU高出32倍。

当然,Groq的研发团队,显然对此心知肚明。选择此时大张旗鼓,更像是一种拉投资的举动。

事实上,这已经不是Groq第一次公开“蹭热度”了。

免责声明:数字资产交易涉及重大风险,本资料不应作为投资决策依据,亦不应被解释为从事投资交易的建议。请确保充分了解所涉及的风险并谨慎投资。OKEx学院仅提供信息参考,不构成任何投资建议,用户一切投资行为与本站无关。

和全球数字资产投资者交流讨论

扫码加入OKEx社群

industry-frontier