这次Pi币真的上线主网了!

文章来源:机器之心

图片来源:由无界AI生成

图片来源:由无界AI生成

网友:波士顿动力要整点新舞步,才能让Figure 01下热搜。

「借助 OpenAI 的能力,Figure 01 现在可以与人全面对话了!」

本周三,半个硅谷都在投的明星机器人创业公司 Figure,发布了全新 OpenAI 大模型加持的机器人 demo。

这家公司在 3 月 1 日刚刚宣布获得 OpenAI 等公司的投资,才十几天就直接用上了 OpenAI 的多模态大模型。

如你所见,得到 OpenAI 大模型能力加持的 Figure 01 现在是这个样子的。

它可以为听从人类的命令,递给人类苹果。

将黑色塑料袋收拾进框子里。

将杯子和盘子归置放在沥水架上。

需要强调的是:你看到的这一切,只用到了一个神经网络。

广大网友在看到如此惊艳的 demo 后,对机器人的发展速度感到震惊,我们似乎正处在这场汹涌的进化浪潮中。甚至有人感叹,已经准备好迎接更多的机器人了。

还有网友调侃道:「波士顿动力:好的,伙计们,这是一场真正的竞争。让我们回到实验室,设计更多舞蹈套路。」

所有这些,全是机器人自学的!

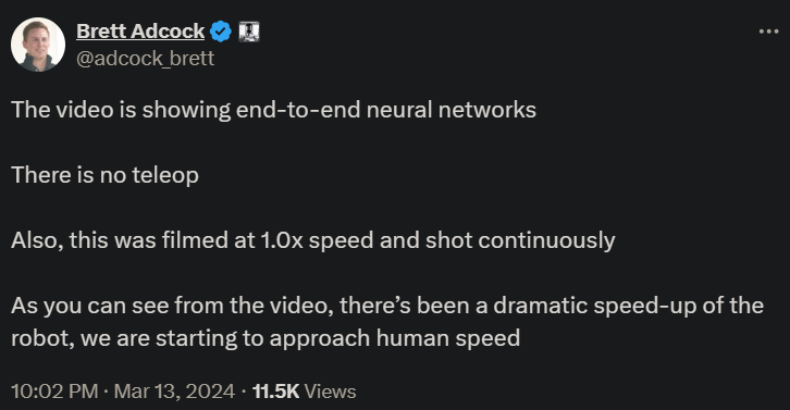

Figure创始人Brett Adcock表示,视频中Figure 01展示了端到端神经网络框架下与人类的对话,没有任何远程操作。并且,机器人的速度有了显著的提升,开始接近人类的速度。

Figure机器人操作高级AI工程师Corey Lynch介绍了此次Figure 01的技术原理。他表示,Figure 01现在可以做到以下这些:

他接着解释道,视频中机器人的所有行为都是学到的(再次强调不是远程操作),并以正常速度(1.0x)运行。

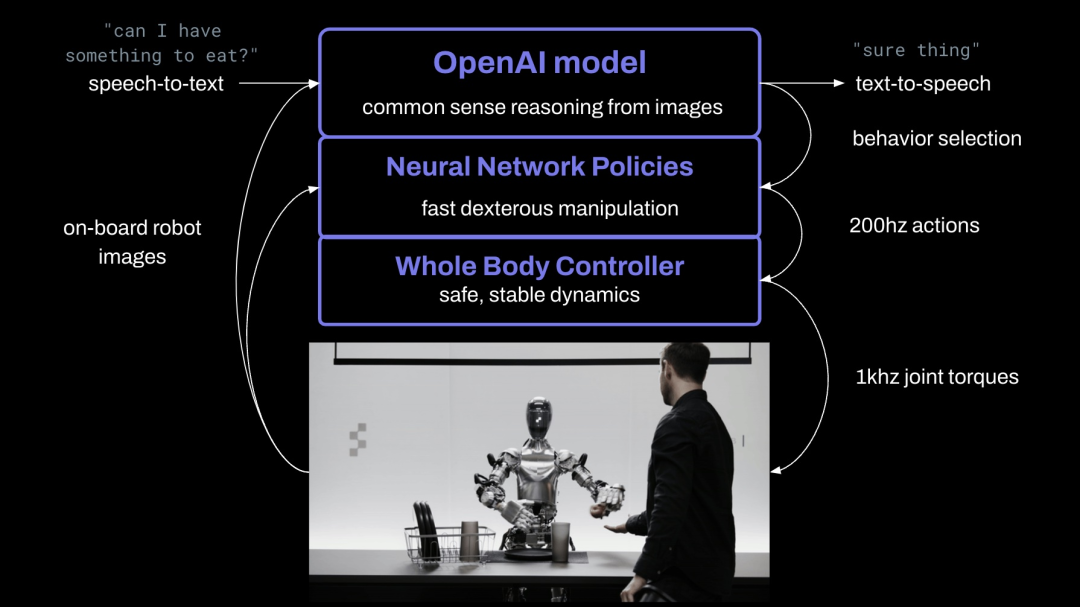

在具体实现过程中,他们将机器人摄像头中的图像输入,并将机载麦克风捕获的语音文本转录到由 OpenAI训练的大型多模态模型中,该模型可以理解图像和文本。该模型对整个对话记录进行处理,包括过去的图像,从而获得语言响应,然后通过文本到语音的方式将其回复给人类。

此外,该模型负责决定在机器人上运行哪些学习到的闭环行为以完成给定的命令,从而将特定的神经网络权重加载到GPU上并执行策略。

免责声明:数字资产交易涉及重大风险,本资料不应作为投资决策依据,亦不应被解释为从事投资交易的建议。请确保充分了解所涉及的风险并谨慎投资。OKEx学院仅提供信息参考,不构成任何投资建议,用户一切投资行为与本站无关。

和全球数字资产投资者交流讨论

扫码加入OKEx社群

industry-frontier