这次Pi币真的上线主网了!

文章来源:科技云报道

图片来源:由无界AI生成

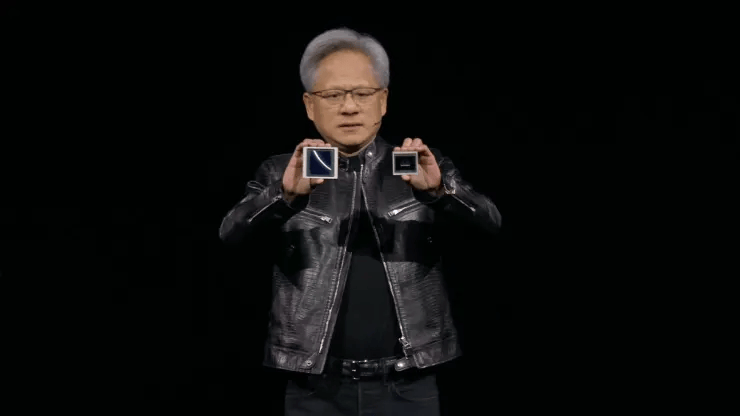

图片来源:由无界AI生成

“我们需要更大的GPU”!

3月19日凌晨,一年一度的“AI风向标”重磅会议——GTC 2024如期而至。

英伟达CEO黄仁勋在大会上发布了包括新一代加速计算平台NVIDIA Blackwell、Project GR00T人形机器人基础模型、Omniverse Cloud API、NVIDIA DRIVE Thor集中式车载计算平台等在内的一系列突破性科技成果。

其中,NVIDIA Blackwell作为英伟达的“王炸”力作,再次将AI芯片的技术标准推向了新的高度。

紧接着,NVIDIA和亚马逊云科技宣布了双方的扩展合作,Blackwell将很快登陆亚马逊云科技,并与亚马逊云科技引以为傲的网络连接、高级虚拟化和超大规模集群等领先技术结合,为数万亿参数规模的大模型推理工作负载带来巨大的性能飞跃。

万亿级参数规模正处在当前全球顶级大模型的实际参数区间,也许用户很快就能在各种生成式AI应用中体验到新硬件带来的提升。

“王炸”AI芯片诞生

训练万亿参数级别的大模型,需要多大规模的算力?

在GTC现场,黄仁勋首先算了一道数学题。以OpenAI最先进的1.8万亿参数大模型为例,该模型需要几万亿的Token进行训练。

万亿参数与数万亿的Token相乘,就是训练OpenAI最先进大模型所需的计算规模。黄仁勋估算,如果用一颗petaflop(每秒钟进行1千万亿次运算)量级的GPU进行运算,需要1000年的时间才能完成。

在Transformer发明后,大模型的规模正在以惊人的速度扩展,平均每6个月就会翻倍,这意味着万亿级别参数并不是大模型的上限。

在这种趋势下,黄仁勋相信,生成式AI的迭代和发展,需要更大的GPU、更快的GPU互连技术、更强大的超级计算机内部连接技术,以及更庞大的超级计算机巨型系统。

一直以来,NVIDIA推出的GPU一般是两种架构,其中面向游戏的GeForce RTX系列GPU是Ada Lovelace架构,面向AI、大数据等应用的专业级显卡是Hopper架构。风靡世界的p00就是基于Hopper架构。

虽然Hopper已经能够满足大部分商用市场的需求,但黄仁勋认为这样还不够:“我们需要更大的GPU,更需要将GPU堆叠在一起。”

于是,同时用以上两种架构类型的产品Blackwell诞生了。Blackwell是英伟达祭出的第六代芯片架构。这块小小的GPU,集成了2080亿个晶体管,拥有着超强的算力,也颠覆了此前所有的产品。

据黄仁勋透露,英伟达为该芯片的研发投入了100亿美元。这一新架构以加州大学伯克利分校数学家David Harold Blackwell命名。他专门研究博弈论和统计学,也是第一位入选美国国家科学院的黑人学者。

Blackwell在单芯片训练方面的FP8性能是其上一代架构的2.5倍,在推理方面的 FP4 性能是其上一代架构的5倍。它具有第五代NVLink互连,速度是Hopper的两倍,并且可扩展至576个GPU。

所以,Blackwell不是一个芯片,而是一个平台。

NVIDIA GB200 Grace Blackwell超级芯片通过900GB/s超低功耗的片间互联,将两个NVIDIA B200 Tensor Core GPU与NVIDIA Grace CPU相连。

其巨大的性能升级,能为人工智能公司提供20 petaflops或每秒2万亿次计算的AI性能,相较于p00,大语言模型性能提升30倍,同时能耗只有1/25。

不难看出,Blackwell平台如此卓越的性能提升,是为了下一代生成式AI做准备。而从OpenAI最近发布的Sora和已经开始研发更强大、更复杂的GPT-5模型也能看出,生成式AI的下一步是多模态和视频,也就意味着更大规模的训练。Blackwell带来了更多可能性。

如今,从谷歌的无边搜索引擎,到亚马逊的云顶天堂,再到特斯拉的智能驾驶,各大科技巨头正纷纷加入NVIDIA的Blackwell阵营,开启了一场令人兴奋的AI加速计算盛宴。

亚马逊、谷歌、戴尔、Meta、微软、OpenAI、Oracle、特斯拉等行业翘楚都在争先恐后地布局,准备在AI新时代大展身手。

难掩战略焦虑

受益于去年以来生成式AI的火爆,2月21日盘后,英伟达公布的最新一季度财报再次打破市场预期。

免责声明:数字资产交易涉及重大风险,本资料不应作为投资决策依据,亦不应被解释为从事投资交易的建议。请确保充分了解所涉及的风险并谨慎投资。OKEx学院仅提供信息参考,不构成任何投资建议,用户一切投资行为与本站无关。

和全球数字资产投资者交流讨论

扫码加入OKEx社群

industry-frontier