这次Pi币真的上线主网了!

文章来源:新智元

图片来源:由无界AI生成

图片来源:由无界AI生成

在计算的历史上,曾被丢弃或过时的想法仍然很有趣,有时甚至非常有用。

在这方面,我们这辈子能经历的最重要的例子莫过于神经网络了。

多数人可能都了解,在神经网络近70年的历史中,寒冬和泡沫交替出现,——事实上,藏在神经网络背后的专用硬件加速器(ASIC)也是如此。

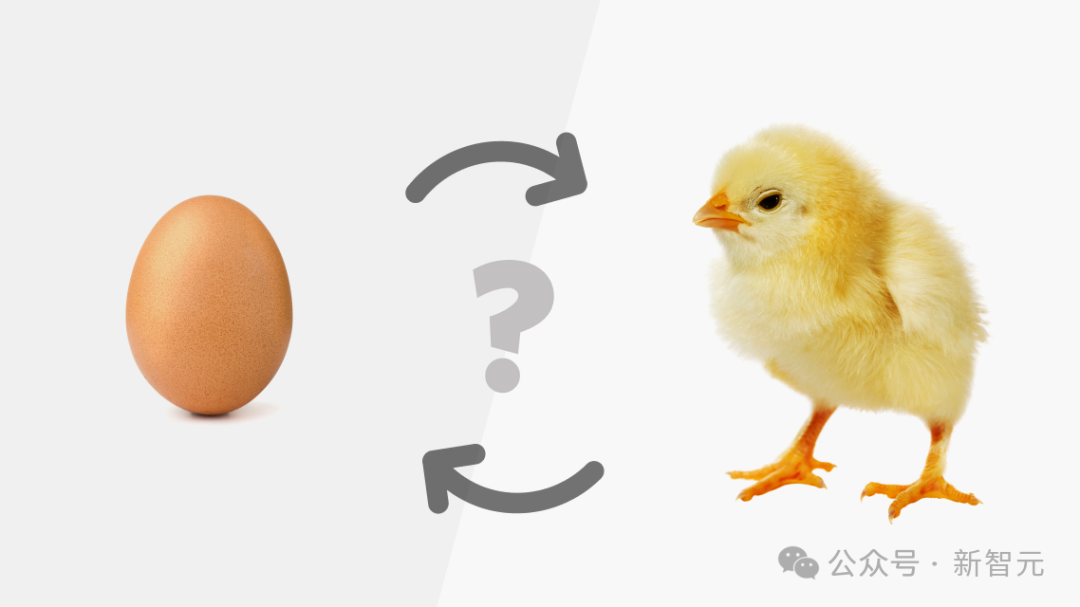

神经网络和ASIC属于是「先有鸡还是先有蛋」的关系,大家都知道神经网络在CPU上效率不高,但是,如果没有证据证明神经网络是有用的,公司凭什么要为神经网络投资开发专门的硬件?

然而,正因为没有合适的硬件,神经网络也work不起来......

在历史的周期演进中,构建专用硬件的项目一次又一次地被放弃,最终,作为外来者的GPU打破了僵局。

毫无疑问,我们现在正处于泡沫周期,在大模型的激励下,从初创公司到超大规模企业,都在构建建立自己的硬件加速器。

他们之中的大多数都可能会失败,但也肯定会有成功的设计成为未来计算领域的重要组成部分。

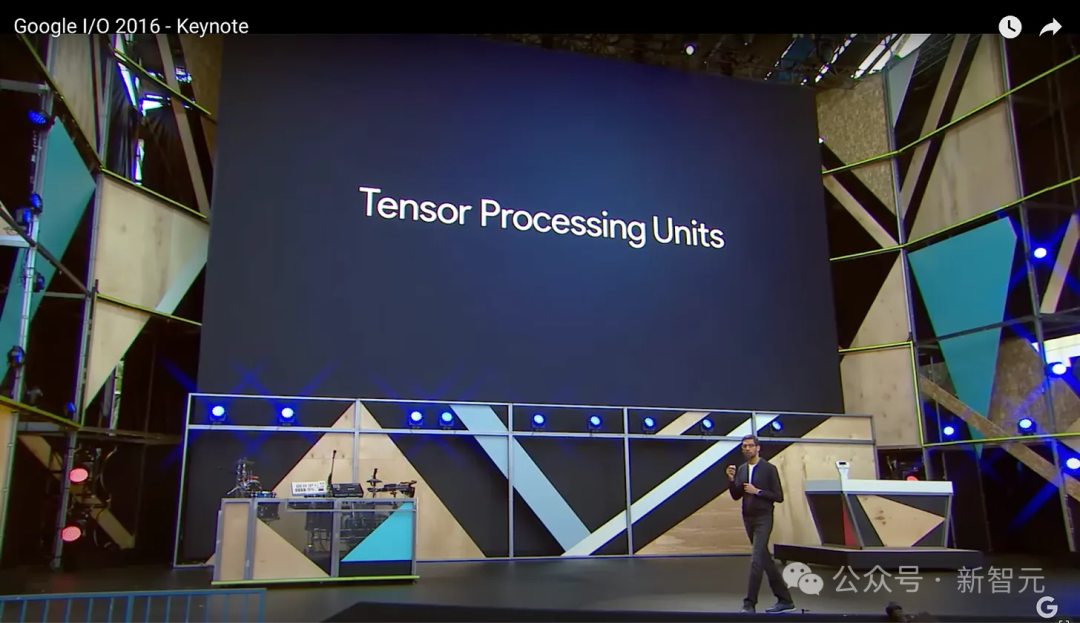

——而谷歌的张量处理单元(TPU)作为第一批大规模部署的加速器,肯定会成为幸存者之一。

当我们在谈论TPU时,我们在谈论什么

为什么谷歌的TPU既有趣又重要?因为这是谷歌,TPU被切实应用于谷歌庞大的服务(搜索、Android、Chrome、Gmail、地图、Play 商店、YouTube、照片),用户超过10亿。此外,谷歌还拥有第三大公共云。

在英伟达的GPU主导了这个AI时代硬件供应的当下,谷歌的TPU是一个真正经历了时间和规模考验的竞品。

以下的内容,小编分成两部分:第一部分讲故事,关于第一个谷歌TPU的前世今生;第二部分讲技术,揭秘TPU的架构细节和性能。

起源

机器学习对谷歌来说是一件大事。毕竟谷歌的既定使命是「组织世界信息,使其普遍可用和有用(to organize the world's information and make it universally accessible and useful)」。

机器学习帮助谷歌发掘信息的价值,从图像和语音识别到语言翻译,再到大型语言模型,当然也少不了谷歌的「摇钱树」——年入数十亿美元的广告业务。

2010年代初,谷歌的注意力开始转向深度学习:

2011年:Jeff Dean、Greg Corrado和Andrew Ng发起了关于深度学习的研究项目——Google Brain。

2013年:继AlexNet图像识别项目取得成功后,谷歌以4400万美元的价格收购了由Geoffrey Hinton、Alex Krizhevsky和Ilya Sutskever组成的初创公司。

2014年:谷歌收购了由Demis Hassabis、Shane Legg和Mustafa Suleyman创立的DeepMind,价格高达65000万美元

2013年,当AlexNet的开发者Alex Krizhevsky来到谷歌时,他发现谷歌现有的模型都在CPU上运行。

于是,在公司工作的第一天,他出去从当地的一家电子商店买了一台GPU机器,把它插入网络,然后开始在GPU上训练神经网络。

最终,大家意识到需要自己需要更多的GPU,2014年,谷歌决定以约13000万美元的价格购买40,000个英伟达GPU。

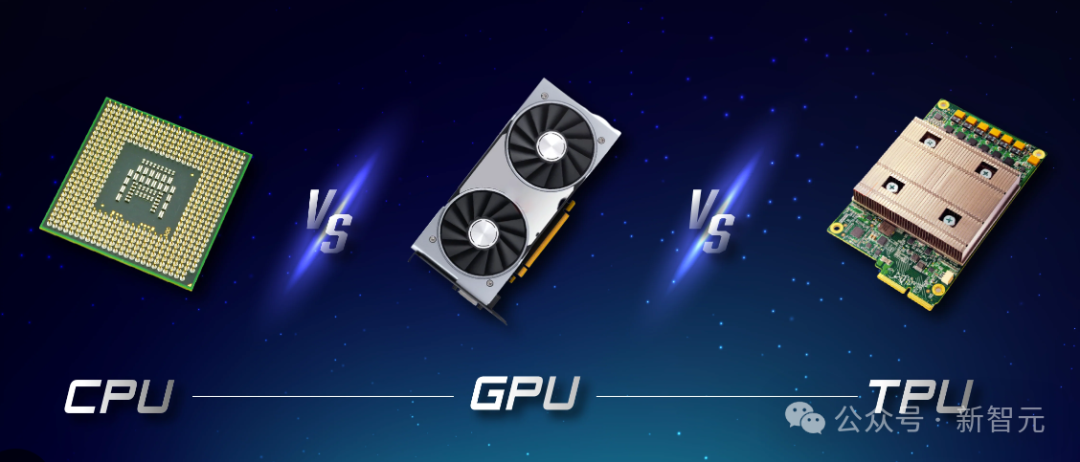

深度学习所提供的能力可以大规模应用于谷歌的各种业务,然而,无论是在技术上还是在战略上,依赖英伟达GPU都不一定是最佳解决方案。

GPU不是ASIC,它不是为神经网络量身打造的,对于需要大规模应用的谷歌来说,相当于要付出很大的额外代价;同时,依赖单一供应商显然也是战略上的重大风险。

谷歌当时有两种选择:现场可编程门阵列(FPGA)和专用集成电路(ASIC)。

当时的实验证明,FPGA的性能打不过GPU,而定制ASIC可能在推理方面产生10倍的性价比优势。

快速交付

免责声明:数字资产交易涉及重大风险,本资料不应作为投资决策依据,亦不应被解释为从事投资交易的建议。请确保充分了解所涉及的风险并谨慎投资。OKEx学院仅提供信息参考,不构成任何投资建议,用户一切投资行为与本站无关。

和全球数字资产投资者交流讨论

扫码加入OKEx社群

industry-frontier