金色早报丨比特币市值占

文章来源:锌产业

图片来源:由无界AI生成

图片来源:由无界AI生成

4月16日,李彦宏在百度AI开发者大会上给出了文心一言经历2023年百模大战后的战况数据:

用户数突破2亿,服务企业8.5万家,AI原生应用数超过19万。

另外,他还透露,百度内部每天新增代码有27%是由Comate(AI代码助手)生成。

作为国内布局大模型最激进的互联网巨头之一,百度给出的这组数据,印证了大模型对于互联网公司带来的巨大影响。

实际上,大模型带来的影响远不止于此,李彦宏说,“未来开发应用将会像拍短视频一样简单。”

或许是身处这波变革的漩涡之中,也或许是错失过云计算那波时代红利,李彦宏针对大模型发表的言论一直都很激进。

无论大模型能否像李彦宏预期的那样颠覆互联网时代的生产模式,一个不可忽视的事实是,这波大模型浪潮背后,本质上依然是算力之争。

要想在缓缓开启的大模型时代获得先机,访存密集、近存计算、类脑计算、存算一体等先进制式芯片的研发,是绕不开的竞争焦点。

就在上周,在第十三届吴文俊人工智能科学技术奖颁奖典礼的系列活动上,进行了一场关于大模型时代芯片产业发展的圆桌讨论。

在这次圆桌上,中国科学院自动化所研究员&中科南京人工智能创新研究院副院长程健、中国科学院微电子所研究员尚德龙、上海科技大学教授哈亚军、北京忆芯科技有限公司首席架构师黄好城四位芯片领域专家就:

1、大模型需要怎样的云边端芯片?

2、机器人需要怎样的芯片来实现通用人工智能?

3、大模型在芯片设计中有怎样的应用?

4、芯片产业需要怎样的生态?

这四个关键问题展开了一场激烈讨论。

本文就此次圆桌讨论内容进行了不改变原意的整理,以供大家参考学习。

01

大模型时代的云边端芯片

问:大模型时代,云、边、端芯片分别具有怎样的发展机遇和挑战?

程健:要回答这个问题,我们先要看,今天所谓的大模型和过去传统模型到底有什么区别。

这其中有很多区别,但是没有太多本质区别,特别是在芯片架构上没有太多区别。

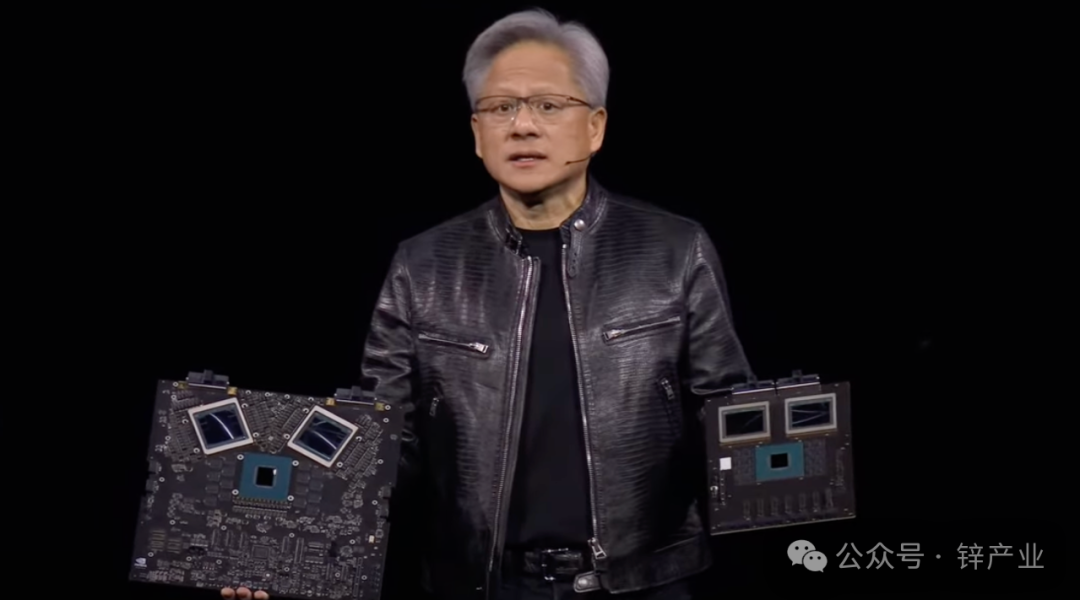

首先是云端芯片,我们看今天英伟达的GPU,它是通过不断堆显存、拓宽带宽来提升性能,除了工艺改进外,更多是通过增加硬件成本来提升算力。

对于我们来说,要想弯道超车,就要看能否通过存算一体、三维堆叠等方式,探索出一些新的路径。

云端追求的是奥运精神,更快、更高、更强,在边缘和终端侧,和云端又有着不同的场景和需求。

在边缘和终端侧,由于受到体积、成本、功耗等限制,无法追求更高、更快、更强,尤其还有不同的场景和应用需求,这时给我们做芯片其实提供了更多机会。

例如很多团队将模型和算法做到一起,有的芯片架构也变了,例如ASIC模式等。

这其中能做的东西、需要定制化的东西很多,也有更多的机会。

尚德龙:我同意程老师的见解,大模型需要高算力,这是挑战也是机遇。

大模型本质上是生成式AI模型,生成式AI模型的一大缺陷是不能生成知识,不能生成知识要如何展现通用智能,这是我要提出的一个问题。

从云边端的机遇上来看,不能只看芯片,还要结合算法来研究。

类脑计算本身是一个非常大的系统,我们是否可以从现有的算法和类脑算法融合来实现通用人工智能,这是一个值得思考的问题。

另一方面,类脑计算的一个重要出发点是高效,人脑的功率不到20瓦,一个馒头顶一天没有问题;

一台机器的功率有几百瓦、上千瓦,我们是否可以从算法设计理念上,通过融合来实现云边端的一些创新设计思路。

现在来看,无论是先进的架构、先进的封装,还是Chiplet,即便是将众多芯片封装在一起,功耗依然是个问题,在云边端用起来还会有一些限制。

这就需要一些新的设计方法、设计理念,来促进这些领域的发展。

哈亚军:我们现在进入到了一个通用智能时代,很多时候,大家希望用一个平台解决通用的问题。

实际上,在各类模型出现之前,计算架构也曾有过同样的问题——究竟应该用一个通用的计算平台,还是用专用的计算平台来解决问题?

免责声明:数字资产交易涉及重大风险,本资料不应作为投资决策依据,亦不应被解释为从事投资交易的建议。请确保充分了解所涉及的风险并谨慎投资。OKEx学院仅提供信息参考,不构成任何投资建议,用户一切投资行为与本站无关。

和全球数字资产投资者交流讨论

扫码加入OKEx社群

industry-frontier