爆火AIGC产品卷翻海外营销

原创:学术头条

原文题目:《AIGC 下一站:期待、警惕充斥着 AI 剪辑师的世界》

图片来源:由无界版图AI工具生成

上月底,名为“chaindrop”的 Reddit 用户,在 r/StableDiffusion subreddit 上分享了一个由人工智能生成的视频,在业内引起了不小的争议。

视频中,一个由 AI 生成的丑陋畸形的“威尔・史密斯”,以一种可怕的热情将一把意大利面条铲进嘴里。这一“地狱般”的视频迅速传播到其他形式的社交媒体,数字媒体和广播公司 Vice 表示该视频将“伴随你的余生”,美国娱乐网刊 The A.V. Club 称其为“AI 开发的自然终点”。仅在 Twitter 上,这一视频的观看次数就超过了 800 万。

下面这段动图是其中的部分内容。每一帧都以不同的角度展示了模拟的威尔・史密斯狼吞虎咽地吃着意大利面的场景。

自从威尔・史密斯吃意大利面的视频疯狂传播后,互联网上就出现了斯嘉丽・约翰逊和乔・拜登吃意大利面等后续报道,甚至还有史密斯吃肉丸子的视频。尽管这些可怕的视频正在成为互联网中完美且“恐惧”模因素材,但就像之前的文生图以及每一种 AI 生成的内容一样,文生视频(Text2 Video)正加速走进我们的生活。

文生视频:你写脚本,我做视频

“威尔・史密斯吃意大利面”的视频出自开源 AI 工具 ModelScope 模型,创建这一视频的工作流程相当简单:仅需给出“Will Smith eating spaghetti”的提示,并以每秒 24 帧(FPS)的速度生成。

据了解,ModelScope 是一种“文生视频”扩散模型,经过训练可以通过分析收集到 LAION5 B、ImageNet 和 Webvid 数据集中的数百万张图像和数千个视频,根据用户的提示来创建新视频。这包括来自 Shutterstock 的视频,因此在其输出上有幽灵般的“Shutterstock”水印,就像视频中所展示的那样。

目前,在文生视频这一赛道,国内外大厂和研究机构也在悄然竞争。早在去年 9 月 29 日,Meta 就发布了 Make-A-Video,在最初的公告页面上,Meta 展示了基于文本生成的示例视频,包括“一对年轻夫妇在大雨中行走”和“一只正在画肖像的泰迪熊”。

同时,Make-A-Video 具备拍摄静态源图像并将其动画化的能力。例如,一张海龟的静止照片,一旦通过 AI 模型处理,就可以看起来像是在游泳。

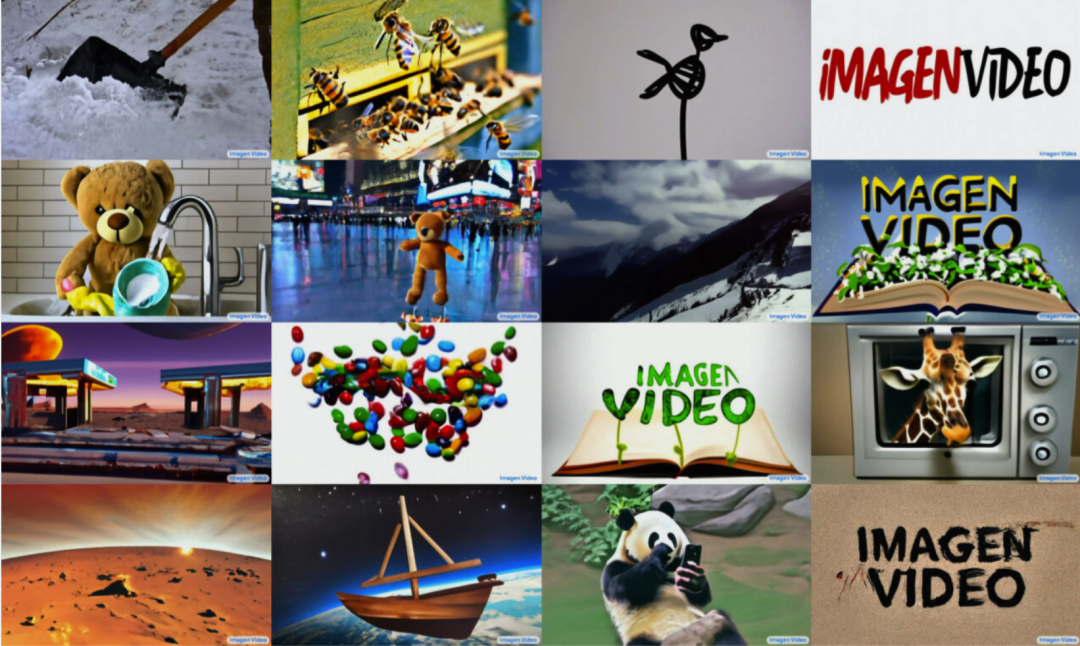

仅仅在 Meta 推出 Make-A-Video 不到一周后,Google 便发布了 Imagen Video,它能够根据书面提示以每秒 24 帧的速度生成 1280×768 的高清晰视频。Imagen Video 包括几个显著的风格能力,例如根据著名画家的作品(如梵高的画作)生成视频,生成 3 D 旋转对象同时保留对象结构,以及渲染文本多种动画风格。Google 希望,这一视频合成模型能够“显著降低高质量内容生成的难度”。

随后,Google 推出了另一个文生视频模型 Phenaki。区别于 Imagen Video 主打视频品质,Phenaki 主要挑战视频长度。它可以根据详细提示创建更长的视频,实现“有故事、有长度”。它生成任意时间长度的视频能力来源于其新编解码器 CViVIT——该模型建立在 Google 早期文生图系统 Imagen 中磨练的技术之上,但在其中加入了一堆新组件,从而可以将静态帧转换为流畅的运动。

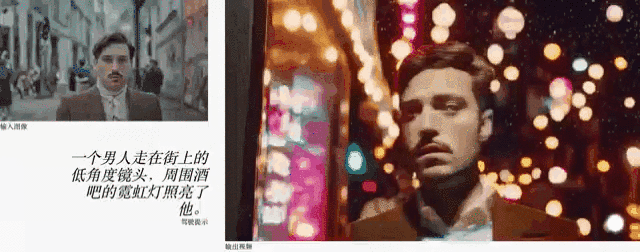

今年 2 月 6 日,Stable Diffusion 背后的原始创业公司 Runway 推出了视频生成 AI——Gen-1 模型,可以通过使用文本提示或者参考图像所指定的任意风格,将现有视频转换为新视频,改变其视觉风格。3 月 21 日,Runway 发布 Gen-2 模型,专注于从零开始生成视频,通过将图像或文本提示的构图和样式应用于源视频的结构(视频到视频),或者,只使用文字(文生视频)。

踩在 "文生图" 的肩膀上

Make-A-Video 等文生视频模型背后的关键技术——以及为什么它比一些专家预期得更早到来——是因为它踩在了“文生图”技术巨人的肩膀上。

据 Meta 介绍,他们不是在标记的视频数据(例如,描述的动作的字幕描述)上训练 Make-A-Video 模型,而是采用图像合成数据(用字幕训练的静止图像)并应用未标记的视频训练数据,以便模型学习文本或图像提示在时间和空间中可能存在的位置的感觉。然后,它可以预测图像之后会发生什么,并在短时间内显示动态场景。

免责声明:数字资产交易涉及重大风险,本资料不应作为投资决策依据,亦不应被解释为从事投资交易的建议。请确保充分了解所涉及的风险并谨慎投资。OKEx学院仅提供信息参考,不构成任何投资建议,用户一切投资行为与本站无关。

和全球数字资产投资者交流讨论

扫码加入OKEx社群

industry-frontier