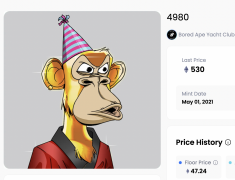

金色无聊猿 BAYC #4980 以约

据 CNBC 5 月 17 日消息,谷歌上周宣布的大型语言模型 PaLM 2 使用的训练数据几乎是其前身的五倍,使其能够执行更高级的编码、数学和创意写作任务。根据 CNBC 查看的内部文件,PaLM 2 是谷歌在 I/O 大会上推出的新型通用大型语言模型,它接受了 3.6 万亿个 token 的训练。谷歌之前版本的 PaLM 于 2022 年发布,并接受了 7800 亿个 token 的训练。

原文链接

免责声明:数字资产交易涉及重大风险,本资料不应作为投资决策依据,亦不应被解释为从事投资交易的建议。请确保充分了解所涉及的风险并谨慎投资。OKEx学院仅提供信息参考,不构成任何投资建议,用户一切投资行为与本站无关。

和全球数字资产投资者交流讨论

扫码加入OKEx社群

industry-frontier