被3500美元“劝退”?苹果

本文系腾讯新闻《潜望》作者 张小珺 发自北京

图片来源:由无界 AI工具生成

半个月前,包括OpenAI CEO Sam Altman、图灵奖得主Geoffrey Hinton在内的数百名人工智能顶尖人士,联名签署了一封关于AI对人类灭绝存在威胁的简短声明。

这声明只有一句话——“减轻人工智能的灭绝风险应该与流行病和核战争等其他社会规模风险一起成为全球优先事项。”

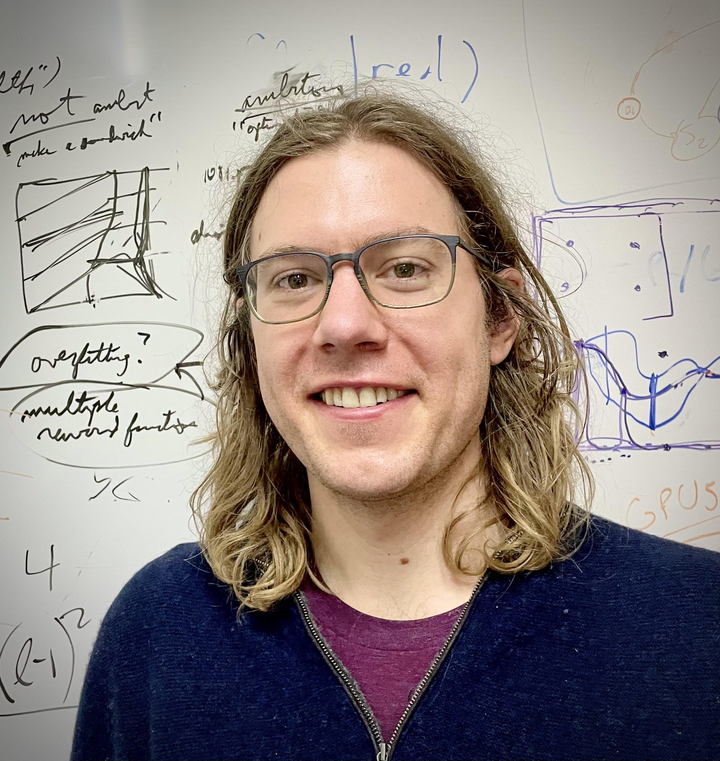

剑桥大学人工智能研究助理教授David Krueger是这封信最早的发起人之一,也是签名者。

6月9日,Krueger在出席2023北京智源大会上期间,与腾讯新闻《潜望》进行了一次深度对话。他长期关注AI对齐与安全问题,从2012年起就开始忧虑人工智能对于人类灭绝的潜在风险,业界将此称为“X-Risk”(An existential risk)。

针对AI风险,一种观点反驳称,这种强烈的担忧可能与几百年前蒸汽机出现时人类的过度惊慌有相似之处。但Krueger称,两者最大不同是,蒸汽机不会让人类灭绝,但AI会。

Krueger认为,AI比人类更聪明,无序的竞争,以及构建对世界产生更直接影响的AI系统——这三重因素都会极大增加人工智能系统失控的风险系数。“系统越是开放、越是自主、越是智能,并且越是旨在实现长期目标,系统失控的风险就越大。”他说。

在他看来,人工智能的安全问题就像全球气候变化问题一样,各方有各自的利益,会有诸多冲突与分歧,最终使之成为复杂的全球协调问题。因此必须尽早开始,通过各方努力,才能让人类不至于沦落至被AI接管的命运。

只有这样,人类才能活下去。

David Krueger

以下为David Krueger的谈话精要。

01《AI风险声明》联名信仅一句话,是精心设计的

腾讯新闻《潜望》:你是《AI风险声明》(Statement on AI Risk)签署者之一,能不能告诉我们,这封声明是怎样诞生的?

David Krueger:我一年多前就有了这样的想法,原因是人们对AI的风险,特别是AI可能会导致人类灭绝的风险越来越关注。与此同时,很多人并没有公开讨论这个问题。

一个重要原因是历史缘故,这个观点曾被视为边缘想法,人们担心公开讨论会给他们带来负面影响,甚至影响职业前景。

几个月前,好时机来了。自从ChatGPT和GPT-4发布,人们对AI的关注达到空前。很长一段时间,人们承认这可能是假设性的未来问题,但现在为时过早。

至于这个声明是如何产生的,我联系了一些同事,包括人工智能安全中心的负责人Dan Hendrycks。我告诉他我们应该做这样一份声明,而且我打算尽快做。但我不确定自己是否有足够的能力完成。它十分紧急。于是,Dan接过这个话题,推动了声明发表。

腾讯新闻《潜望》:你对这封信的措辞提供了什么意见?

David Krueger:我提议只使用一句话来表达。原因有几个。

首先,当你有较长陈述,很可能会有人对其中某些内容持不同意见。

我们在几个月前看到,生命未来研究所(Future of Life Institute)发表呼吁:所有人工智能实验室立即暂停训练比GPT-4更强大的人工智能系统至少6个月。很多人对此的反应是,听起来不错,但我认为我们无法暂停人工智能的发展。

当然他们发表这个声明仍然很有效,因为一旦人们说我们无法暂停,就是我们需要采取行动的迹象。我们确实需要有能力暂停一项过于危险而不应该开发的技术。

我使用这个例子是为了说明,当你说得越多,人们就越有不同意见。在这种情况下,我们没有提如何处理这个风险,因为人们对正确方法有不同看法;我们也没有说为什么它可能导致人类灭绝,因为不同的人对此有不同看法——有些人更担心技术被滥用,另一些人更担心技术失控,而这不是某个恶意行为者故意造成的结果。

无论哪种方式,只要有很多人认同这是巨大风险,我们需要采取行动,那就可以了。

02AI风险与蒸汽机有本质差异

腾讯新闻《潜望》:人们对于人工智能威胁的担忧,与两三百年前人们对蒸汽机的恐惧,最大差别是什么?

David Krueger:对于那段历史,我了解不多。我不确定当时是否有人说过会导致人类灭绝。如果有人这样说过,我也不确定他们会使用什么样的论点,对我来说,似乎不太可能。

关键区别在于我们讨论的是灭绝。我们讨论的是一种可能比人类在各种相关能力上更聪明、更强大的技术。

免责声明:数字资产交易涉及重大风险,本资料不应作为投资决策依据,亦不应被解释为从事投资交易的建议。请确保充分了解所涉及的风险并谨慎投资。OKEx学院仅提供信息参考,不构成任何投资建议,用户一切投资行为与本站无关。

和全球数字资产投资者交流讨论

扫码加入OKEx社群

industry-frontier