被3500美元“劝退”?苹果

有的人加入 OpenAI,有的人成立创业公司,也有的坚守谷歌 AI。当年正是他们共同开启了今天的 AI 大发展时代。

从 ChatGPT 到 AI 画图技术,人工智能领域最近的这波突破或许都要感谢一下 Transformer。

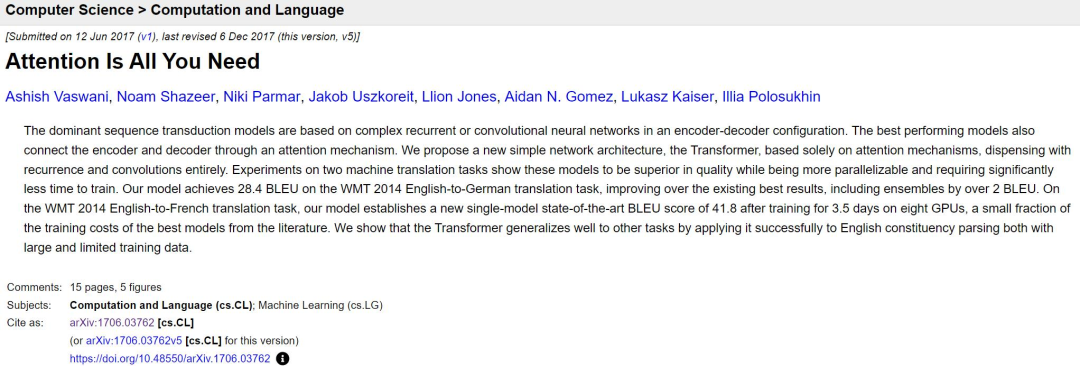

今天是著名的 transformer 论文提交六周年的日子。

论文链接:https://arxiv.org/abs/1706.03762

六年前,一篇名字有点浮夸的论文被上传到了预印版论文平台 arXiv 上,「xx is All You Need」这句话被 AI 领域的开发者们不断复述,甚至已经成了论文标题的潮流,而 Transformer 也不再是变形金刚的意思,它现在代表着 AI 领域最先进的技术。

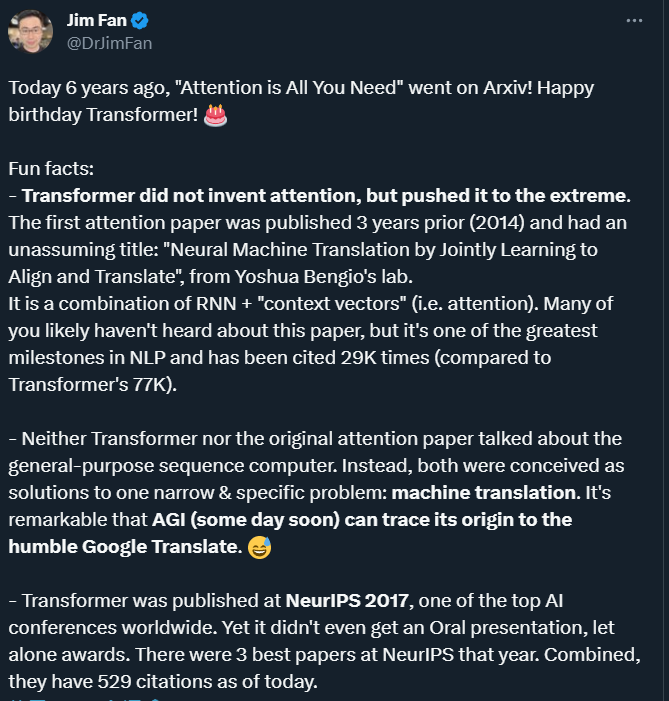

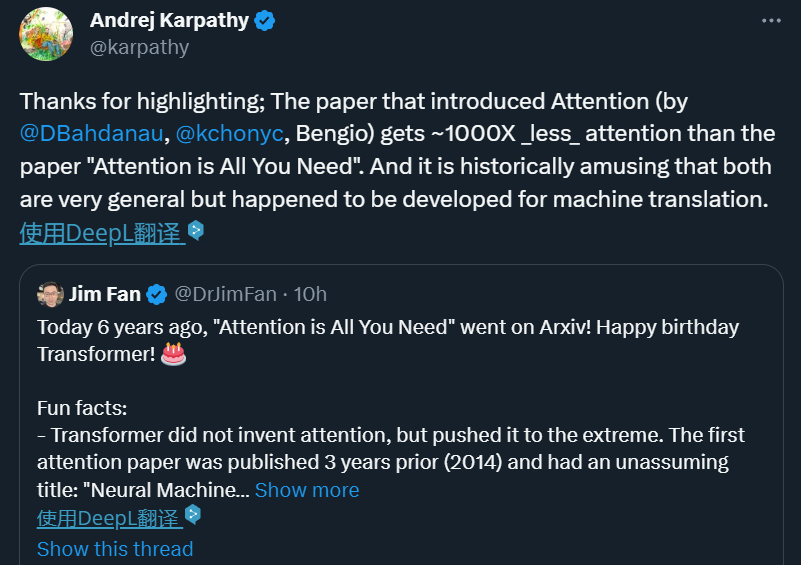

六年后,回看当年的这篇论文,我们可以发现很多有趣或鲜为人知的地方,正如英伟达 AI 科学家 Jim Fan 所总结的那样。

「注意力机制」并不是 Transformer 作者所提出的

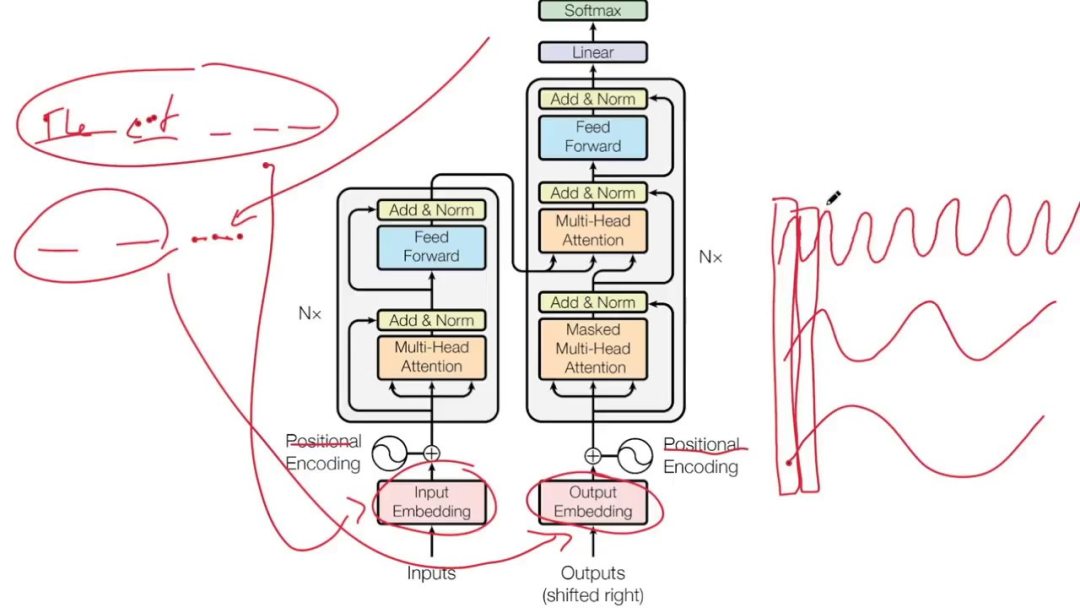

Transformer 模型抛弃了传统的 CNN 和 RNN 单元,整个网络结构完全是由注意力机制组成。

虽然 Transformer 论文的名字是《Attention is All You Need》,我们也因它而不断推崇注意力机制,但请注意一个有趣的事实:并不是 Transformer 的研究者发明了注意力,而是他们把这种机制推向了极致。

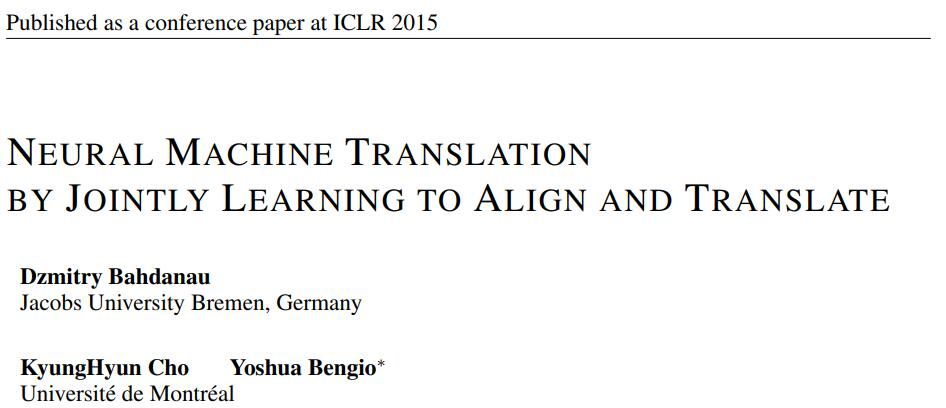

注意力机制(Attention Mechanism)是由深度学习先驱 Yoshua Bengio 带领的团队于 2014 年提出的:

《Neural Machine Translation by Jointly Learning to Align and Translate》,标题比较朴实。

在这篇 ICLR 2015 论文中,Bengio 等人提出了一种 RNN +「上下文向量」(即注意力)的组合。虽然它是 NLP 领域最伟大的里程碑之一,但相比 transformer,其知名度要低得多,Bengio 团队的论文至今已被引用 2.9 万次,Transformer 有 7.7 万次。

AI 的注意力机制,自然是仿照人类的视觉注意力而来。人类大脑里有一种天生能力:当我们看一幅图时,先是快速扫过图片,然后锁定需要重点关注的目标区域。

如果不放过任何局部信息,必然会作很多无用功,不利于生存。同样地,在深度学习网络中引入类似的机制可以简化模型,加速计算。从本质上说,Attention 就是从大量信息中有筛选出少量重要信息,并聚焦到这些重要信息上,忽略大多不重要的信息。

近年来,注意力机制被广泛应用在深度学习的各个领域,如在计算机视觉方向用于捕捉图像上的感受野,或者 NLP 中用于定位关键 token 或者特征。大量实验证明,添加了注意力机制的模型在图像分类、分割、追踪、增强以及自然语言识别、理解、问答、翻译中任务中均取得了明显的性能提升。

引入了注意力机制的 Transformer 模型可以看做一种通用序列计算机(general-purpose sequence computer),注意力机制允许模型在处理输入序列时根据序列中不同位置的相关性分配不同的注意力权重,这使得 Transformer 能够捕捉到长距离的依赖关系和上下文信息,从而提高序列处理的效果。

但在当年,不论是 Transformer 还是最初的 attention 论文都没有谈到通用序列计算机。相反,作者们认为它是解决一个狭窄而具体的问题 —— 机器翻译的机制。所以未来的我们追溯起 AGI 的起源时,说不定可以追溯到「不起眼」的谷歌翻译。

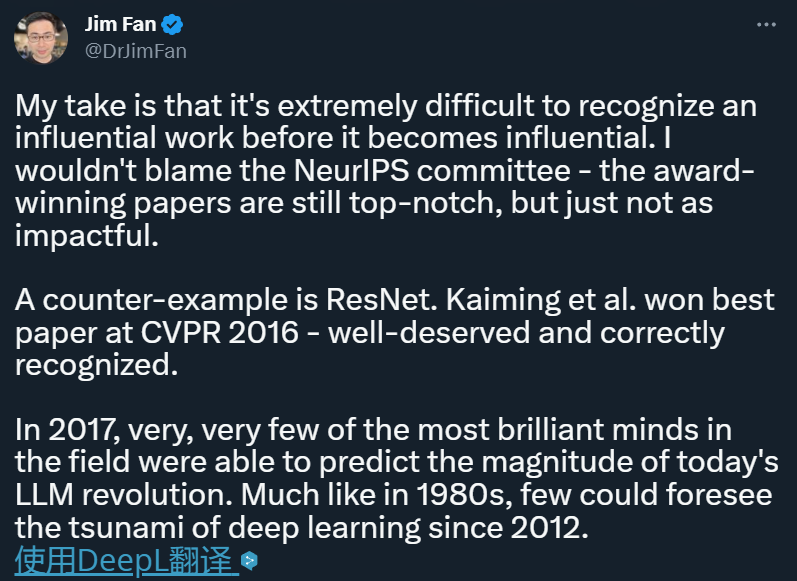

虽然被 NeurIPS 2017 接收,但连个 Oral 都没拿到

Transformer 这篇论文虽然现在影响力很大,但在当年的全球顶级 AI 会议 NeurIPS 2017 上,连个 Oral 都没拿到,更不用说拿到奖项了。当年大会共收到 3240 篇论文投稿,其中 678 篇被选为大会论文,Transformer 论文就是被接收的论文之一,在这些论文中,40 篇为 Oral 论文,112 篇为 Spotlight 论文,3 篇最佳论文,一篇 Test of time award 奖项,Transformer 无缘奖项。

虽然无缘 NeurIPS 2017 论文奖项,但 Transformer 的影响力大家也是有目共睹的。

Jim Fan 评价说:在一项有影响力的研究变得有影响力之前,人们很难意识到它的重要性,这不是评委的错。不过,也有论文足够幸运,能够第一时间被发现,比如何恺明等人提出的 ResNet,当年获得了 CVPR 2016 最佳论文,这一研究当之无愧,得到了 AI 顶会的正确认可。但在 2017 年那个当下,非常聪明的研究者也未必能够预测现在 LLM 带来的变革,就像 20 世纪 80 年代一样,很少有人能预见到 2012 年以来深度学习带来的海啸。

八位作者,人生各自精彩

当时这篇论文的作者共有 8 位,他们分别来自谷歌和多伦多大学,五年过去了,大部分论文作者都已离开了原机构。

免责声明:数字资产交易涉及重大风险,本资料不应作为投资决策依据,亦不应被解释为从事投资交易的建议。请确保充分了解所涉及的风险并谨慎投资。OKEx学院仅提供信息参考,不构成任何投资建议,用户一切投资行为与本站无关。

和全球数字资产投资者交流讨论

扫码加入OKEx社群

industry-frontier