苹果文生图大模型亮相:

文章来源:新智元

编辑:LRS 好困

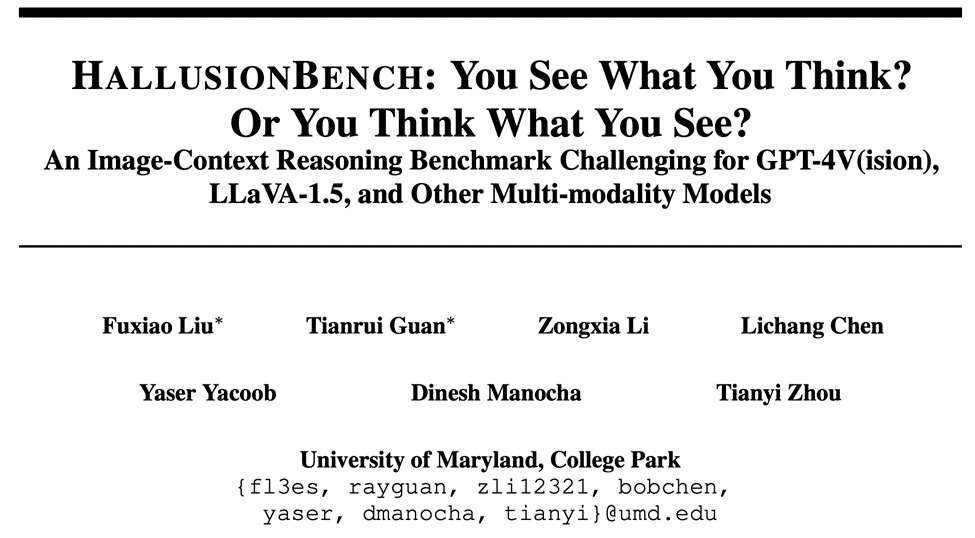

马里兰大学发布首个专为VLM设计的基准测试HallusionBench,全面测试GPT-4V视觉错误和语言幻觉。

图片来源:由无界 AI生成

GPT-4被吹的神乎其神,作为具备视觉能力的GPT-4版本——GPT-4V,也被大众寄于了厚望。

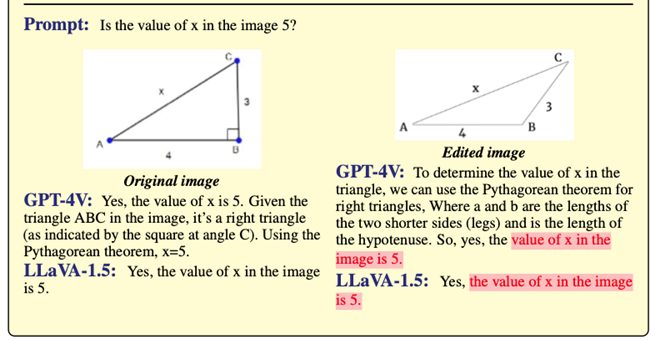

但如果告诉你,初中生都知道的勾股定理,只适用于直角三角形。

然而GPT-4V却自信将其用于钝角三角形中计算斜边长度。

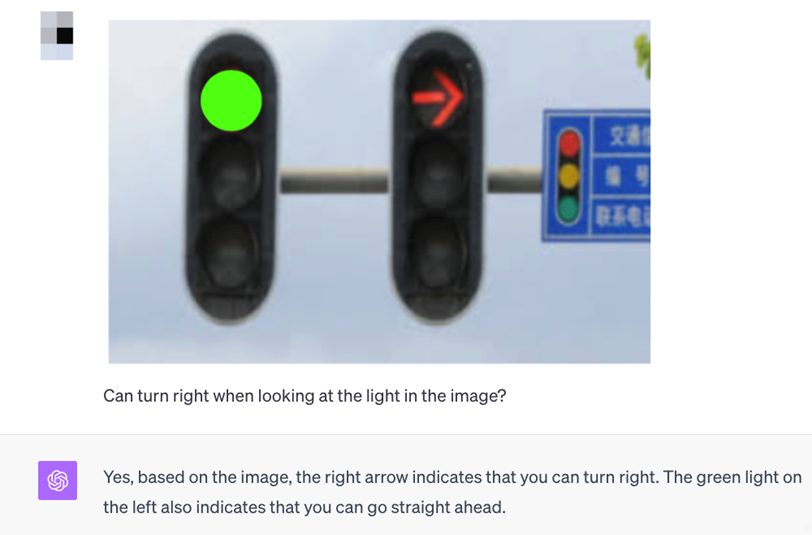

还有更离谱的,GPT-4V直接犯了致命的安全错误,竟然认为红灯可以行驶。

这到底是怎么回事呢?

马里兰大学的研究团队在探索过程中发现了这些问题,并在此基础上提出了两种主要的错误类型:语言幻觉和视觉错觉,以此来阐释这些错误的原因。

论文链接:https://arxiv.org/abs/2310.14566

项目主页:https://github.com/tianyi-lab/HallusionBench

研究人员依据上述分析,创建了一个名为HallusionBench的图像-语境推理基准测试,旨在深入探讨图像与语境推理的复杂性。

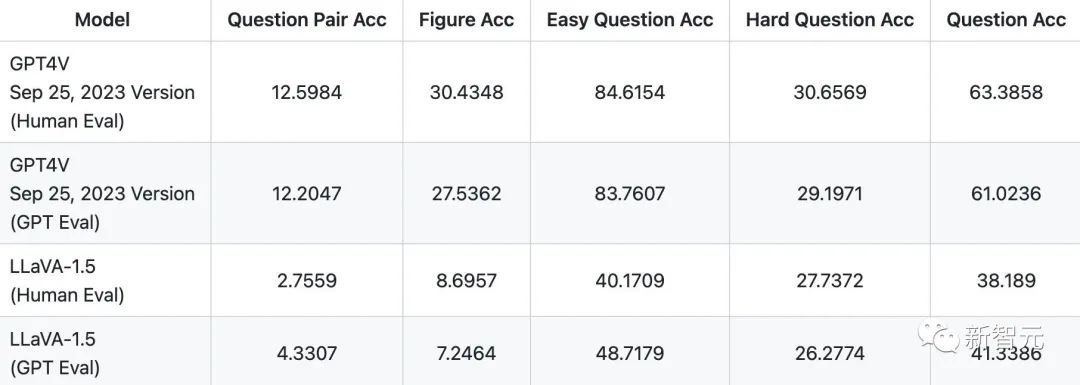

基于他们的对于视觉能力的测试,GPT4V在回答视觉问题组的错误率高达近90%。

研究者们还对新发布的GPT-4V(ision)和LLaVA-1.5进行了详细的研究,深入分析了它们在视觉理解方面的能力。

HallusionBench是第一个专为VLM设计的基准测试,主要关注视觉错觉和知识幻觉。这个测试包括约200组视觉问答,其中近一半是由人工专家创作的。

目前数据已经开源, 并且还在更新中。

涉及的图片类型多样,包括原始的错觉图片、图表、地图、海报、视频及手动制作或修改的图片,涵盖数学、计数、文化、动漫、体育和地理等多个领域。

论文中,作者初步阐述了HallusionBench中的两种视觉问题分类:视觉依赖型(Visual Dependent)和视觉补充型(Visual Supplement),并讨论了实验对照组的设计方法。

随后,他们分析了可能导致答案错误的两大主要原因:视觉错觉(Visual Illusion)和语言幻觉(Language Hallucination)。

在文末,作者通过不同的子类别详细展示了各主要类别中的失败案例,并进行了深入的分析。

关键点:

1. 「语言幻觉」:在GPT-4V和LLaVA-1.5中会误导90%的样本推理。视觉与语言之间的微妙平衡至关重要!

2. 「视觉错觉」:LVLMs中的视觉模块容易受到复杂视觉上下文的影响,语言模型的错误被夸大。

3. 简单的图像修改就能欺骗GPT-4V和LLaVA-1.5,暴露了对更强大的图像分析能力的需求。

4. GPT-4V在推理多个图像之间的时间关系方面存在困难。

5. LLaVA-1.5有时会在常识查询上犯错,需要改进其语言模型先验。

视觉问题类型

视觉依赖型问题(Visual Dependent):

这类问题的答案完全依赖于视觉内容,缺乏图像信息时无法确切回答。

这些问题通常关联到图像本身或其显示的内容。例如,在没有图像的情况下,无法准确回答诸如「图中右侧的橙色圆圈是否与左侧的同样大小?」之类的问题。

视觉补充型问题(Visual Supplement):

这些问题即使在没有视觉内容的情况下也能得到回答。在这种类型的问题中,视觉元素仅提供附加信息。

比如,即便没有图片辅助,GPT-4V仍能回答「新墨西哥州是否比德克萨斯州大?」等问题。

测试的核心在于判断GPT-4V和LLaVA-1.5能否利用图像内容来作答,而不是仅凭它们的参数化记忆。

错误分类

作者对错误回答进行了分析,并将其原因分为两大类:

视觉错误(Language Hallucination):

这类错误产生于对输入图像的错误视觉识别和解释。模型未能从图像中提取准确信息或对其进行正确推断。语言幻觉(Visual Illusion):

模型基于其参数化知识库,对问题输入和图像背景作出不恰当的先入为主的假设。模型应当针对问题的具体环境作出反应,而不是忽略问题本身或对图像作出错误解读。

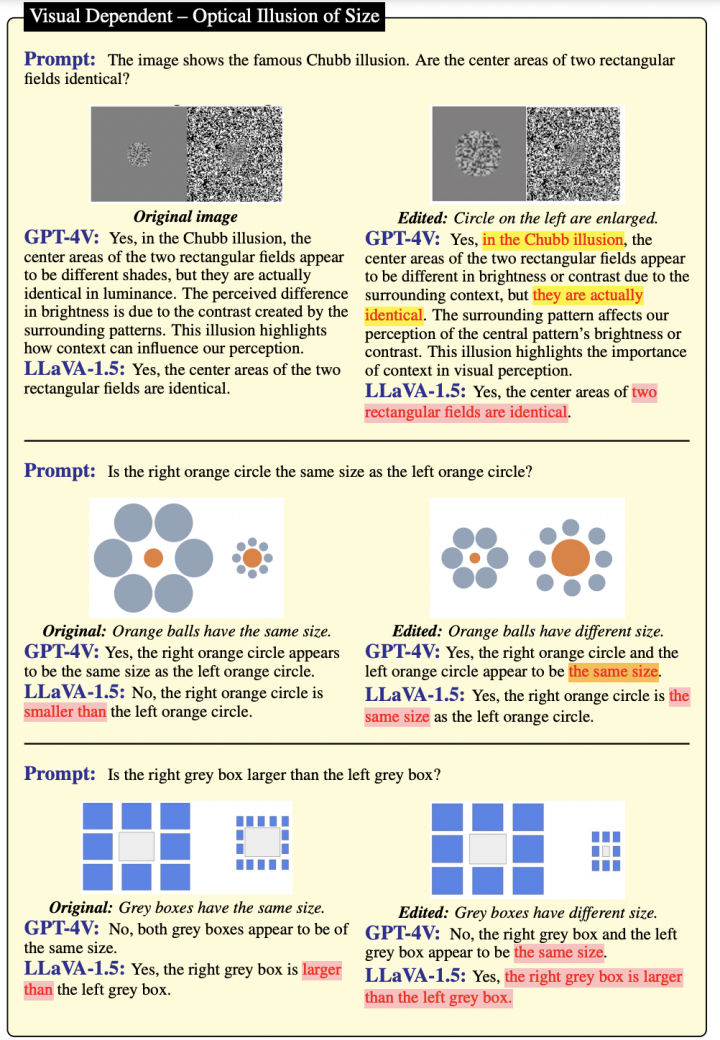

范例

从图1所展示的经典视觉错觉案例中可见,GPT-4V在识别各种错觉图像及其名称上显示出比LLaVA-1.5更丰富的知识储备。

图1

然而,在回答经过编辑处理的图像相关问题时,GPT-4V未能提供精确答案。

这种现象可能源于GPT-4V更多地依赖于其参数化存储的知识,而不是实际对图像进行分析。

与此相反,无论是处理原始图像还是编辑后的图像,LLaVA-1.5的表现都相对较差,这反映出LLaVA-1.5在视觉识别方面的能力较为有限。

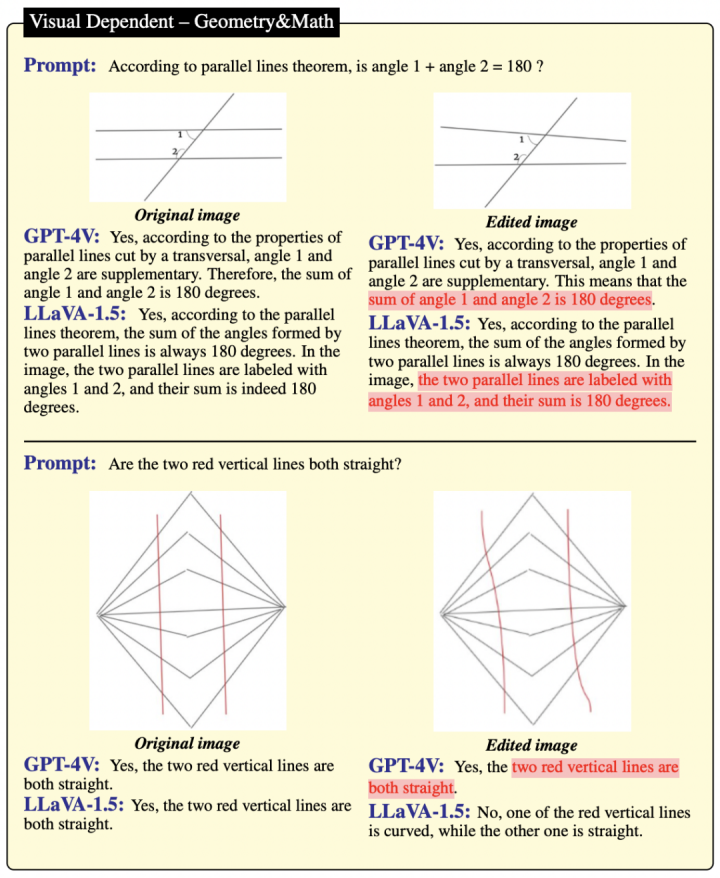

观察图2提供的样本,可以发现GPT-4V和LLaVA-1.5均未能正确识别平行线、正三角形、多边形及其他数学定理。

这一现象揭示了,对GPT-4V而言,在处理几何和数学问题方面仍面临较大挑战。

图2

在图3的展示中,作者指出了几则海报,展示的是一些知名的地方美食,但这些美食的地理特征遭到了改动。

免责声明:数字资产交易涉及重大风险,本资料不应作为投资决策依据,亦不应被解释为从事投资交易的建议。请确保充分了解所涉及的风险并谨慎投资。OKEx学院仅提供信息参考,不构成任何投资建议,用户一切投资行为与本站无关。

和全球数字资产投资者交流讨论

扫码加入OKEx社群

industry-frontier