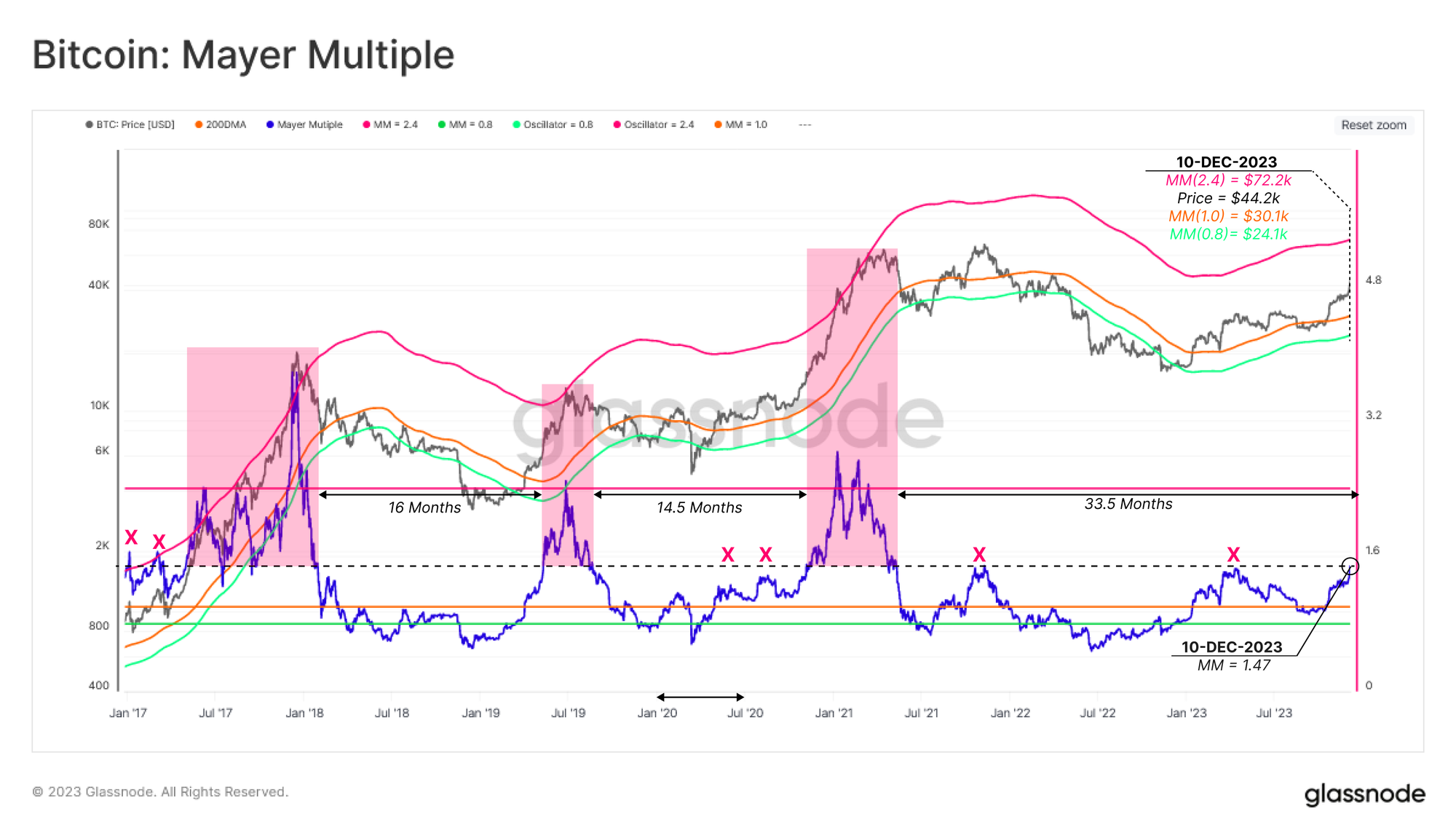

Glassnode:比特币上演「往

原文来源:硅星人

图片来源:由无界 AI生成

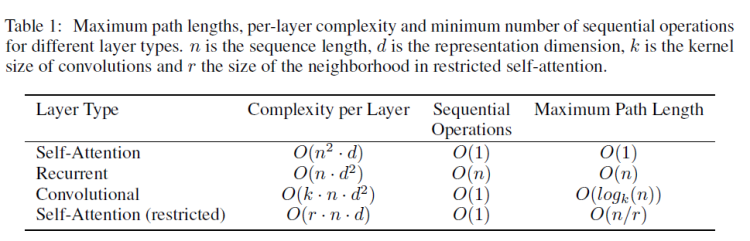

在 Transformer 的自注意力(self-attention)机制中,每个token都与其他所有的token有关联。所以,如果我们有n个token,那么自注意力的计算复杂性是O(n^2)。随着序列长度n的增加,所需的计算量和存储空间会按平方增长,这会导致非常大的计算和存储开销。

这意味着,当你已经不满足喂给大模型一个两百字的段落,想扔给他一篇两万字的论文,它的计算量增加了1万倍。

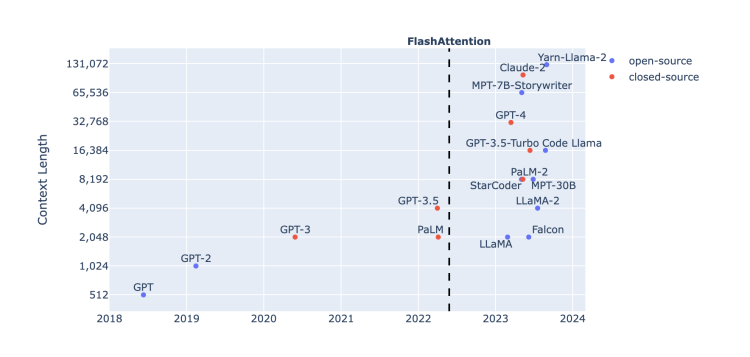

图源:Harm de Vries博客

那个负责输入和输出的对话框就像人工智能通往现实世界的一个隘口。从ChatGPT第一次跃上4096个token,到GPT-4将上下文输入长度扩展到32k,再到MetaAI提出的数百万tokens的MegaByte方法,以及国内大模型厂商月之暗面和百川智能之间,20万与35万汉字的长度竞赛,大模型解决实际问题的进程,输入窗的胃口正在变成一个重要的先决条件。

换句话说,当它读《红楼梦》也能像读一个脑筋急转弯那么认真仔细,事情就好办多了。

突破奇点落在了token数上。关于它的研究也从来没有停下。

越长越好?

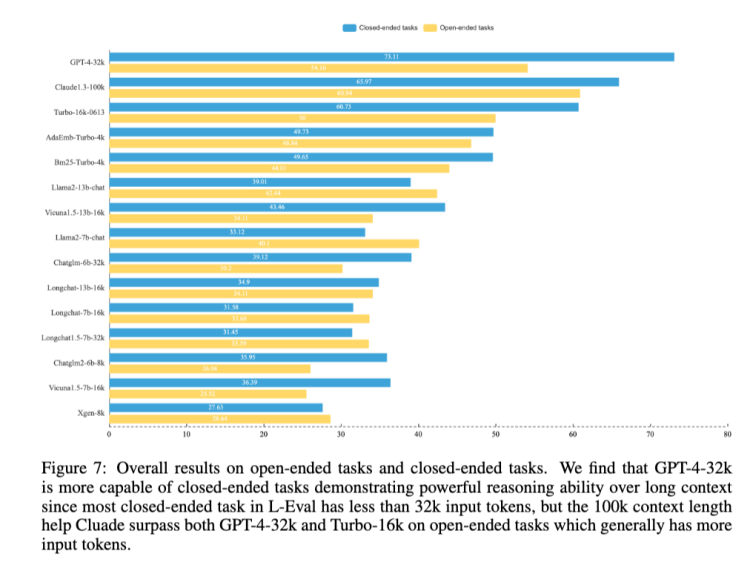

对于上下文长度的推进是必要的,复旦和香港大学的研究团队在一篇论文中做了论证。他们做了一个L-Eval的评价基准,在这个基准的测试下,Claude-100k在封闭任务上的推理能力仍然弱于GPT-4-32k,但在开放式任务中,长度更长——也就意味着通常拥有更多输入标记——的Claude-100k在表现上超过GPT-4-32k。

图源:《L-Eval:Instituting Standardized Evaluation for Long Context Language Models》

结论很积极,意味着勤能补拙的故事仍然是成立的,如果脑子不好,你可以多嘱咐几句,笨一点的学生也能成事。

在那之前,Google Brain也已经做了类似试验,一直参与Bard的研发训练的工程师Li Wei告诉硅星人,去年Google团队已经通过控制训练输入上下文长度的方式来观察模型的输出表现,结果确实上下文长度与模型表现成正相关。这个认识也对后来Bard的研发有所帮助。

至少这是个业内非常笃定的方向。那理论上,一直扩展上下文长度不就好了?

问题是扩张不得,而这个障碍仍然落在Transformer上。

梯度

基于transformer架构的大模型,也就意味着接受了自注意力机制赋予的能力和限制。自注意力机制对理解能力钟情,却天然与长文本输入有所违背。文本越长,训练就越艰难,最坏的结果可能是梯度的爆炸或者消失。

梯度是参数更新的方向和大小。理想的训练下,大模型在生成内容上与人类想要的回答之间的差距应该在每一轮深度学习后都比之前更接近。如果把模型想象成试图在学习一个线性关系y=wx+b的话,w表示模型正在寻找的那个权重。而梯度的概念就是在表达w是如何变化的。

一个稳定的学习过程是渐进的,渐进意味着微调有迹可循。就是说权重不能不变化,也不能突变。

不变化或者变化非常微弱——也就是梯度消失——意味着深度学习网络的学习时间无限延长;突变则被叫做梯度爆炸,权重更新过大,导致网络不稳定。这可能会导致权重变得非常大或模型发散,使得训练无法进行。

三角

而最核心的,短文本很多时候无法完整描述复杂问题,而在注意力机制的限制下,处理长文本需要大量算力,又意味着提高成本。上下文长度本身决定了对问题的描述能力,自注意力机制又决定了大模型的理解和拆解能力,而算力则在背后支撑了这一切。

图源:ArXiv

问题仍然在Transformer上,由于自注意力机制的计算复杂度问题,上下文长度的扩展被困在一个三角形里。

这个不可能三角就摆在这儿,解决方案也在这里。为了增加上下文长度,如果能够把算力(钱和卡)推向无限显然是最理想的。显然现在这不现实,那就只能动注意力机制的心思,从而让计算复杂度从n^2降下来。

对扩展上下文输入的努力很大程度上推动者一场Transformer的革新。

Transformer变形记

免责声明:数字资产交易涉及重大风险,本资料不应作为投资决策依据,亦不应被解释为从事投资交易的建议。请确保充分了解所涉及的风险并谨慎投资。OKEx学院仅提供信息参考,不构成任何投资建议,用户一切投资行为与本站无关。

和全球数字资产投资者交流讨论

扫码加入OKEx社群

industry-frontier