BTC ETF截止日到来:SEC已收

文章来源:机器之心

图片来源:由无界 AI生成

这几天,家务活都被机器人抢着干了。

前脚来自斯坦福的会用锅的机器人刚刚登场,后脚又来了个会用咖啡机的机器人 Figure-01 。

只需给它观看示范视频,加上10个小时的训练,Figure-01 就能学会使用咖啡机,放咖啡胶囊到按下启动键,一气呵成。

但是想要让机器人无师自通,第一次见到各式各样的家具家电,就能在没有示范视频的情况下熟练使用。这是个难以解决的问题,不仅需要机器人拥有强大的视觉感知、决策规划能力,更需要精确的操纵技能。

现在,一个三维具身图文大模型系统为以上难题提供了新思路。该系统将基于三维视觉的精准几何感知模型与擅长规划的二维图文大模型结合了起来,无需样本数据,即可解决与家具家电有关的复杂长程任务。

这项研究由斯坦福大学的 Leonidas Guibas 教授、北京大学的王鹤教授团队,与智源人工智能研究院合作完成。

论文链接:https://arxiv.org/abs/2312.01307

项目主页:https://geometry.stanford.edu/projects/sage/

代码:https://github.com/geng-haoran/SAGE

图 1:根据人类指令,机械臂能够无师自通地使用各种家用电器。

近日,PaLM-E 和 GPT-4V 带动了图文大模型在机器人任务规划中的应用,视觉语言引导下的泛化机器人操控成为了热门研究领域。

以往的常见方法是建立一个两层的系统,上层的图文大模型做规划和技能调度,下层的操控技能策略模型负责物理地执行动作。但当机器人在家务活中面对各种各样从未见过并且需要多步操作的家用电器时,现有方法中的上下两层都将束手无策。

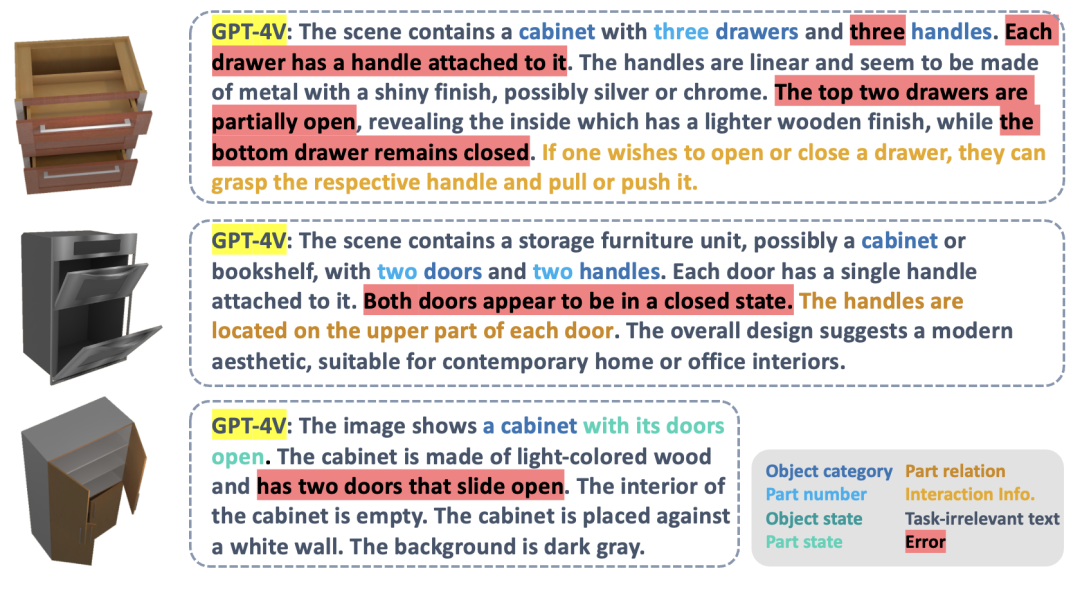

以目前最先进的图文大模型 GPT-4V 为例,虽然它可以对单张图片进行文字描述,但涉及可操作零部件检测、计数、定位及状态估计时,它仍然错误百出。图二中的红色高亮部分是 GPT-4V 在描述抽屉柜、烤箱和立柜的图片时出现的各种错误。基于错误的描述,机器人再进行技能调度,显然不太可靠。

图 2:GPT-4V 不能很好处理计数,检测,定位,状态估计等泛化操控所关注的任务。

下层的操控技能策略模型负责在各种各样的实际情况中执行上层图文大模型给出的任务。现有的研究成果大部分是基于规则生硬地对一些已知物体的抓取点位和操作方式进行了编码,无法泛应对没见过的新物体类别。而基于端到端的操作模型(如 RT-1,RT-2 等)只使用了 RGB 模态,缺乏对距离的准确感知,对新环境中如高度等变化的泛化性较差。

受王鹤教授团队之前的 CVPR Highlight 工作 GAPartNet [1] 启迪,研究团队将重点放在了各种类别的家用电器中的通用零部件(GAPart)之上。虽然家用电器千变万化,但总有几样零件不可或缺,每个家电和这些通用的零件之间存在相似的几何和交互模式。

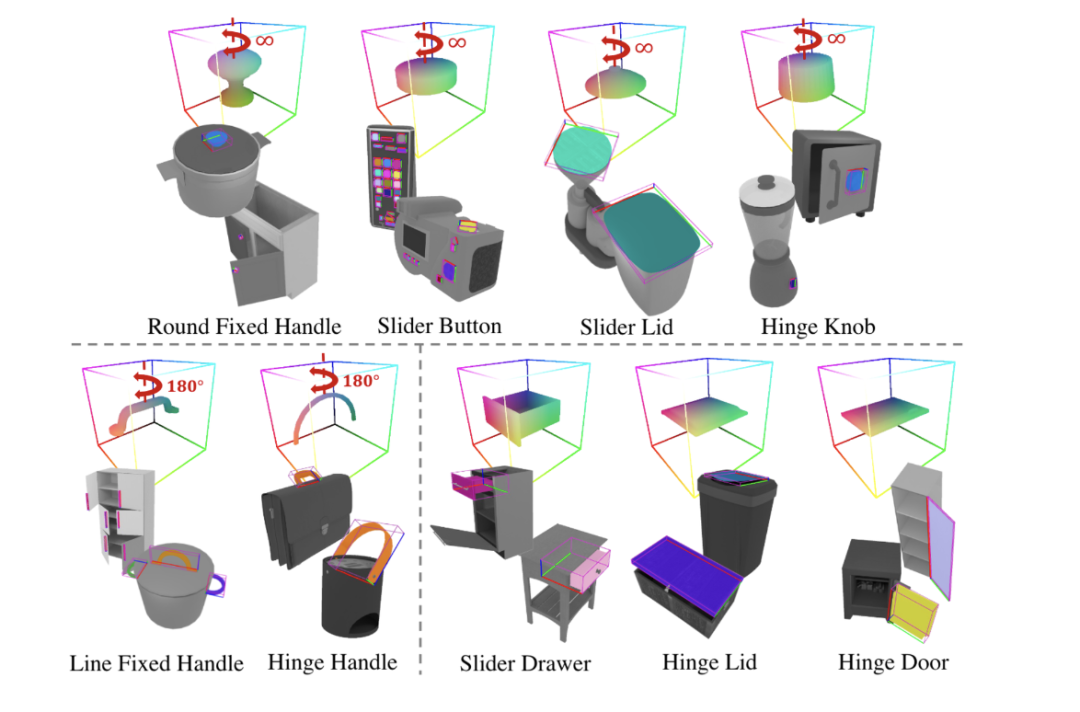

由此,研究团队在 GAPartNet [1] 这篇论文中引入了 GAPart 这一概念。GAPart 指可泛化可交互的零部件。GAPart 出现在不同类别的铰接物体上,例如,在保险箱,衣柜,冰箱中都能找到铰接门这种零件。如图 3,GAPartNet [1] 在各类物体上标注了 GAPart 的语义和位姿。

图3:GAPart:可泛化可交互的零部件[1]。

在之前研究的基础上,研究团队创造性地将基于三维视觉的 GAPart 引入了机器人的物体操控系统 SAGE 。SAGE 将通过可泛化的三维零件检测 (part detection),精确的位姿估计 (pose estimation) 为 VLM 和 LLM 提供信息。新方法在决策层解决了二维图文模型精细计算和推理能力不足的问题;在执行层,新方法通过基于 GAPart 位姿的鲁棒物理操作 API 实现了对各个零件的泛化性操作。

免责声明:数字资产交易涉及重大风险,本资料不应作为投资决策依据,亦不应被解释为从事投资交易的建议。请确保充分了解所涉及的风险并谨慎投资。OKEx学院仅提供信息参考,不构成任何投资建议,用户一切投资行为与本站无关。

和全球数字资产投资者交流讨论

扫码加入OKEx社群

industry-frontier