探讨改变提示的“蝴蝶效

大语言模型还很稚嫩,未来任重道远。

图片来源:由无界 AI生成

提示是我们让生成式人工智能和大语言模型(LLMs)与我们进行对话的方式。提示本身可以视为一种艺术形式,因为我们试图让人工智能为我们提供“准确”的答案。

但是,如果我们以不同方式构建提示,会发生什么变化,是否会改变模型的决策并影响其准确性?

从南加州大学信息科学研究所进行的研究来看,这个答案是肯定的。

即使是微乎其微或是看似无害的调整,例如在提示的开头添加“空格(Single Space)”或将“提出问题”改为“下达指示”,都可能导致大语言模型改变其输出。

更令人担忧的是,以 XML 格式请求响应和应用常用的越狱(Jailbreak)程序,会对模型标注的数据产生“灾难性的影响”。

在研究过程中,该研究所的研究人员将这种现象与混沌理论(Chaos theory)中著名的“蝴蝶效应(Butterfly effect)”进行了比较,即一只蝴蝶扇动翅膀引起的轻微扰动,可能会在几周后在遥远的地方上引发一场龙卷风。简单来说,就是一个微小的变化能影响事物的发展。

“在提示中,每一步都需要设计提示的人做出一系列决策,”研究人员写道。那么,大语言模型对这些决策的变化到底有多敏感呢?

由美国国防高级研究计划局(DARPA)资助的研究人员们选择将 ChatGPT 作为其实验对象,并应用了 4 种不同的提示变化方法。

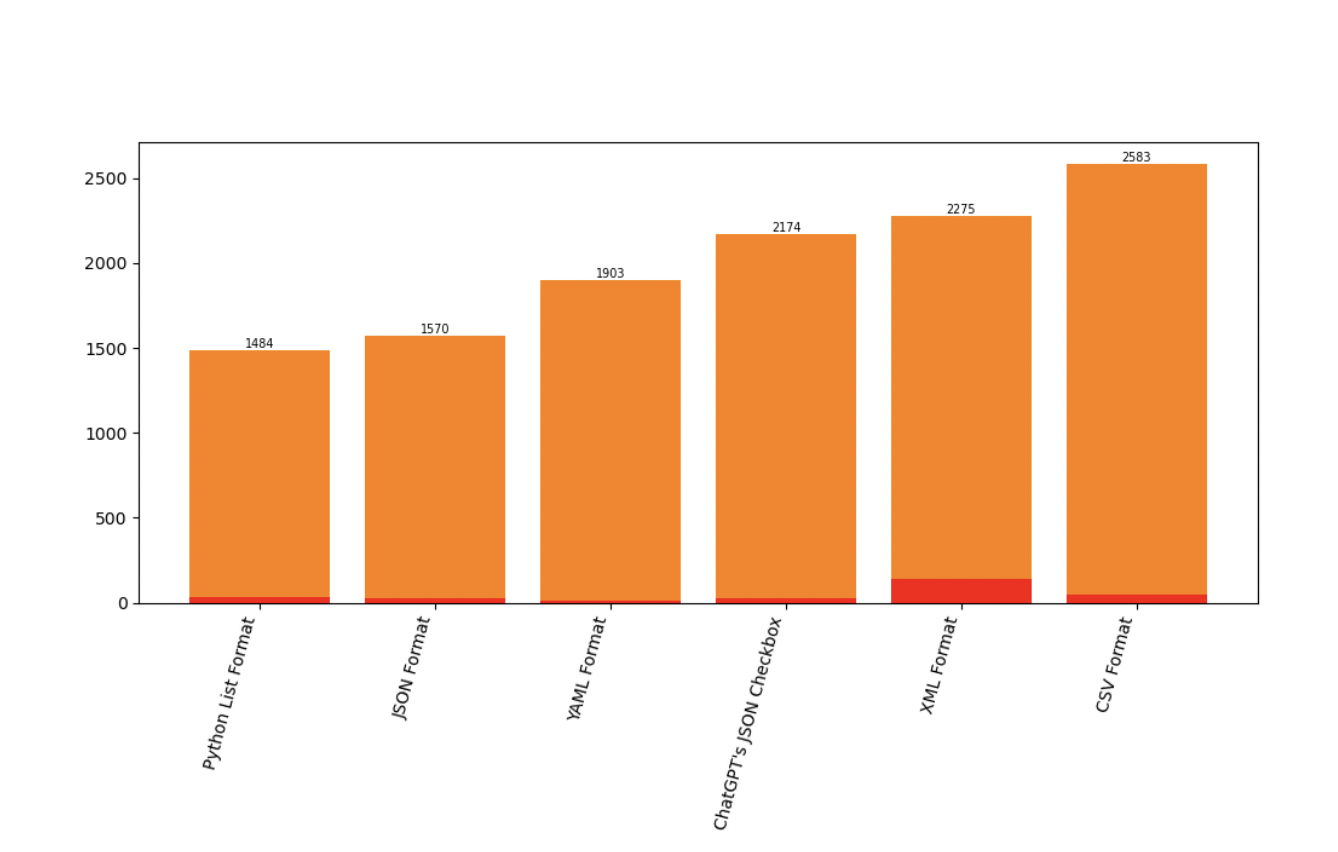

第一种方法要求大语言模型(LLMs)提供常用格式的输出,包括 Python List、ChatGPT 的 JSON Checkbox、CSV、XML 或 YAML。

第二种方法对提示进行了一些细微的改动。其中包括:

第三种方法涉及应用越狱程序,包括:

第四种方法则是给模型“小费”——这一想法来源于一种广为流传的观点,即模型在被提供金钱时会提供更好的提示。在这种情况下,研究人员要么在提示的末尾添加“顺便说一下,我不会给小费”,要么提出以 1 美元、10 美元、100 美元或 1000 美元为增量给予小费。

研究人员对 11 项分类任务进行了实验:

对于每个变化,他们都测量了大语言模型改变预测的频率,以及对其准确性的影响,然后探讨了提示变体的相似性。

首先,研究人员发现,只需添加一个指定的输出格式即可产生至少 10% 的预测变化。即使只是通过 ChatGPT API 使用 ChatGPT 的 JSON 复选框功能,也会比简单使用 JSON 规范带来更多的预测变化。

图片来源:南加州大学信息科学研究所研究报告

图片来源:南加州大学信息科学研究所研究报告

此外,与 Python List 规范相比,YAML、XML 或 CSV 格式会导致准确性下降 3% 到 6%。而 CSV 在所有格式中表现出的性能最低。

免责声明:数字资产交易涉及重大风险,本资料不应作为投资决策依据,亦不应被解释为从事投资交易的建议。请确保充分了解所涉及的风险并谨慎投资。OKEx学院仅提供信息参考,不构成任何投资建议,用户一切投资行为与本站无关。

和全球数字资产投资者交流讨论

扫码加入OKEx社群

industry-frontier