有了GPT-4之后,机器人把转

原文来源:量子位

图片来源:由无界AI生成

大模型“识图”能力都这么强了,为啥还老找错东西?

例如,把长得不太像的蝙蝠和拍子搞混,又或是认不出一些数据集中的稀有鱼类……

这是因为,我们让大模型“找东西”时,往往输入的是文本。

如果描述有歧义或太偏门,像是“bat”(蝙蝠还是拍子?)或“魔鳉”(Cyprinodon diabolis),AI就会大为困惑。

这就导致用大模型做目标检测、尤其是开放世界(未知场景)目标检测任务时,效果往往没有想象中那么好。

现在,一篇被NeurIPS 2023收录的论文,终于解决了这个问题。

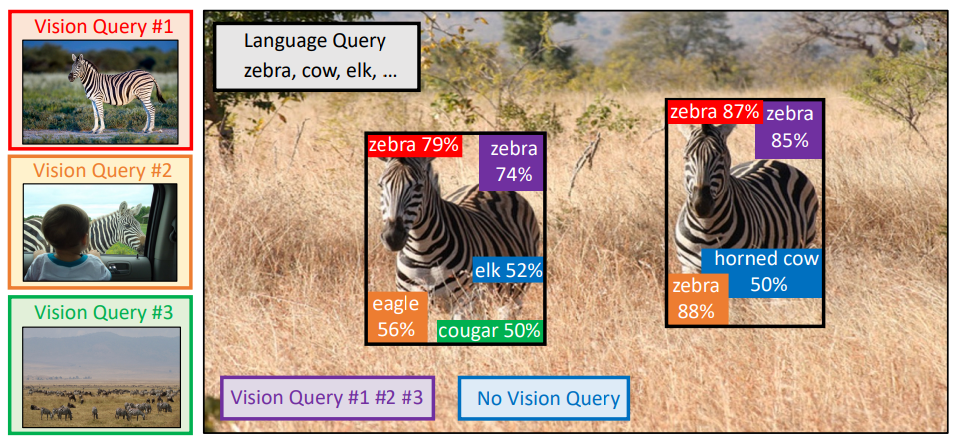

论文提出了一种基于多模态查询的目标检测方法MQ-Det,只需要给输入加上一个图片示例,就能让大模型找东西的准确率大幅提升。

在基准检测数据集LVIS上,无需下游任务模型微调,MQ-Det平均提升主流检测大模型GLIP精度约7.8%,在13个基准小样本下游任务上,平均提高了6.3%精度。

这究竟是怎么做到的?一起来看看。

以下内容转载自论文作者、知乎博主@沁园夏:

目录

MQ-Det:多模态查询的开放世界目标检测大模型

论文名称:Multi-modal Queried Object Detection in the Wild

论文链接:https://arxiv.org/abs/2305.18980

代码地址:https://github.com/YifanXu74/MQ-Det

1.1 从文本查询到多模态查询

一图胜千言:随着图文预训练的兴起,借助文本的开放语义,目标检测逐渐步入了开放世界感知的阶段。为此,许多检测大模型都遵循了文本查询的模式,即利用类别文本描述在目标图像中查询潜在目标。然而,这种方式往往会面临“广而不精”的问题。

例如,(1)图1中的细粒度物体(鱼种)检测,往往很难用有限的文本来描述各种细粒度的鱼种,(2)类别歧义(“bat”既可指蝙蝠又可指拍子)。

然而,以上的问题均可通过图像示例来解决,相比文本,图像能够提供目标物体更丰富的特征线索,但同时文本又具备强大的泛化性。

由此,如何能够有机地结合两种查询方式,成为了一个很自然的想法。

获取多模态查询能力的难点:如何得到这样一个具备多模态查询的模型,存在三个挑战:(1)直接用有限的图像示例进行微调很容易造成灾难性遗忘;(2)从头训练一个检测大模型会具备较好的泛化性但是消耗巨大,例如,单卡训练GLIP 需要利用3000万数据量训练480 天。

多模态查询目标检测:基于以上考虑,作者提出了一种简单有效的模型设计和训练策略——MQ-Det。

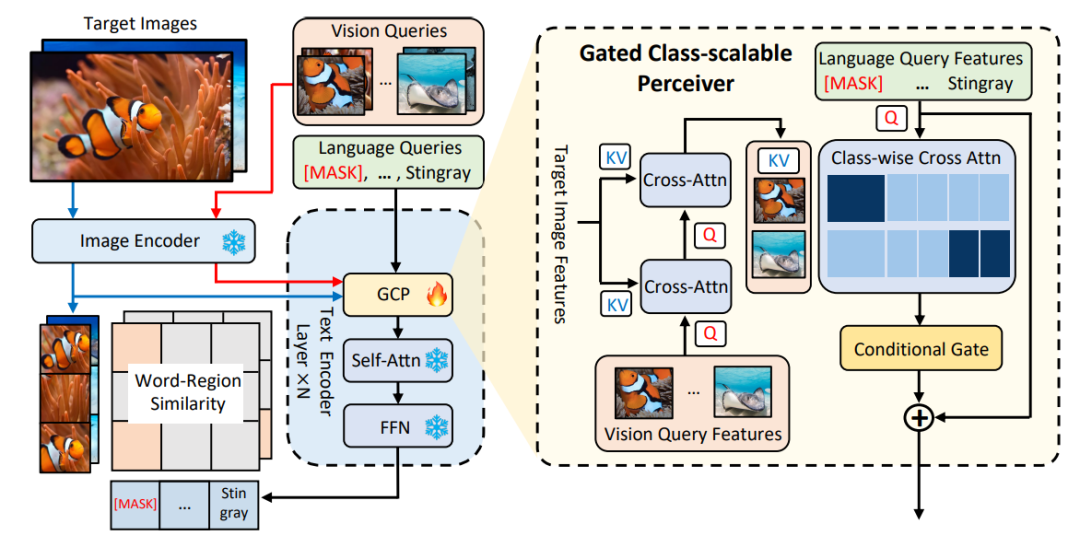

MQ-Det在已有冻结的文本查询检测大模型基础上插入少量门控感知模块(GCP)来接收视觉示例的输入,同时设计了视觉条件掩码语言预测训练策略高效地得到高性能多模态查询的检测器。

1.2 MQ-Det即插即用的多模态查询模型架构

门控感知模块

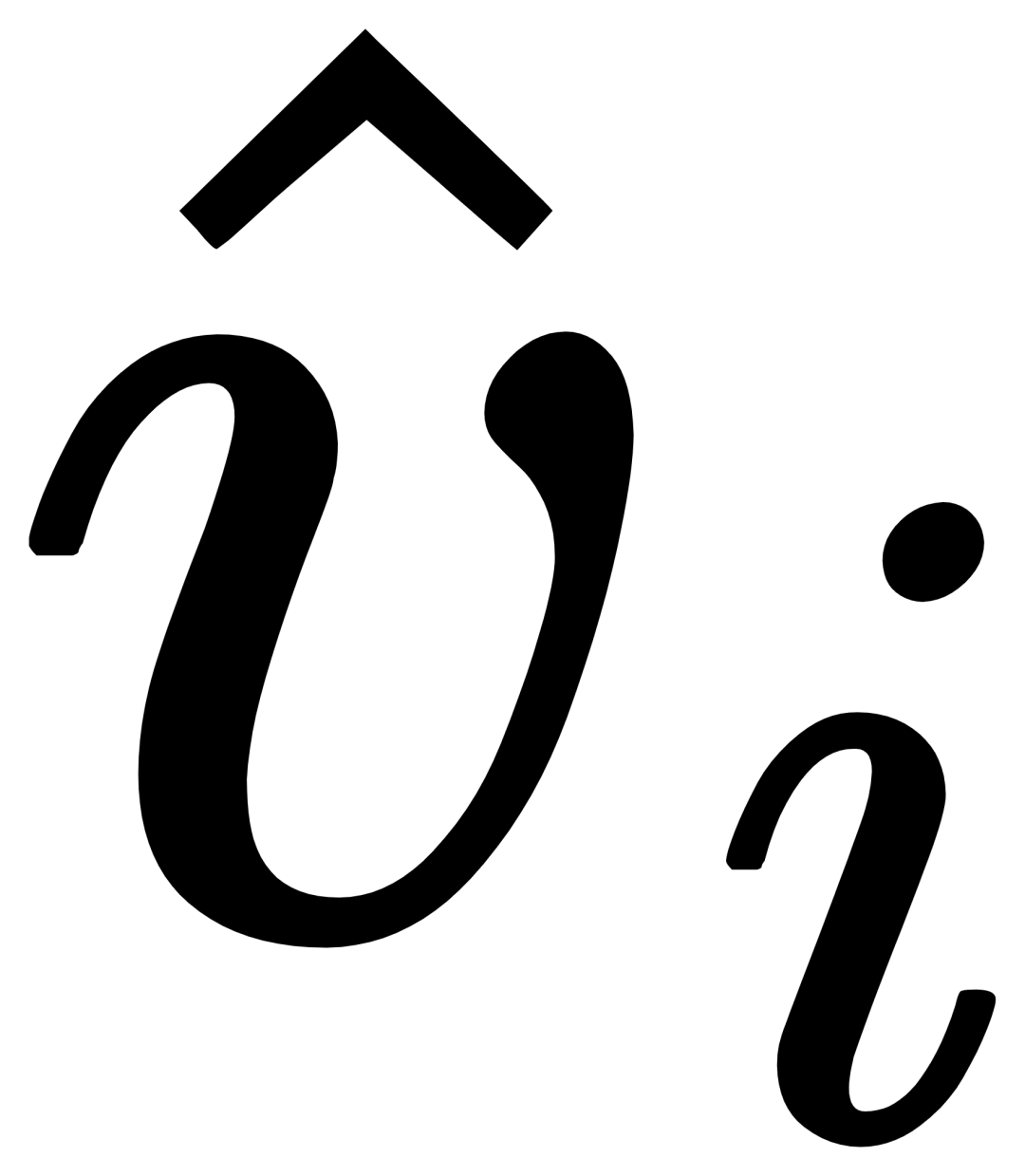

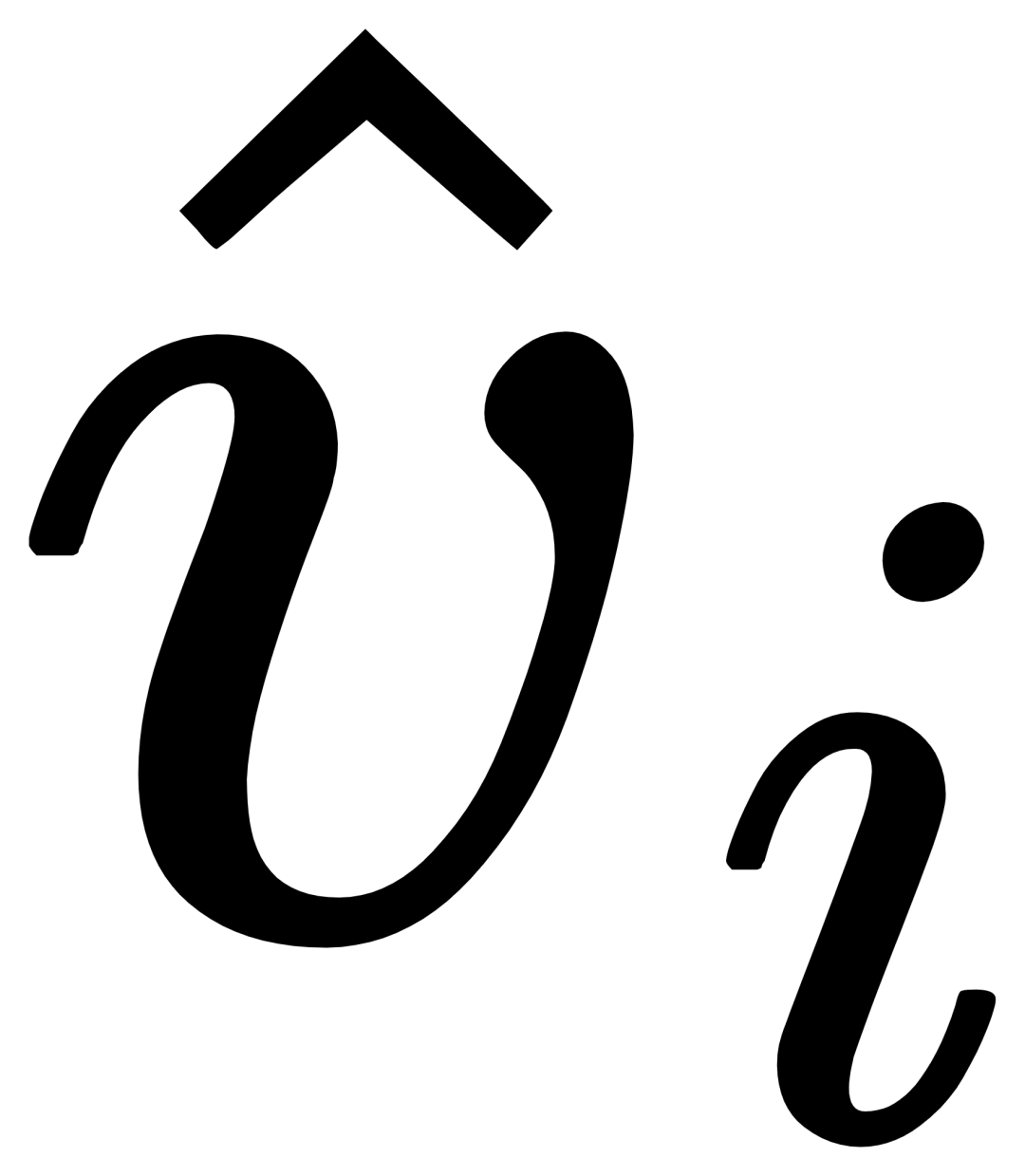

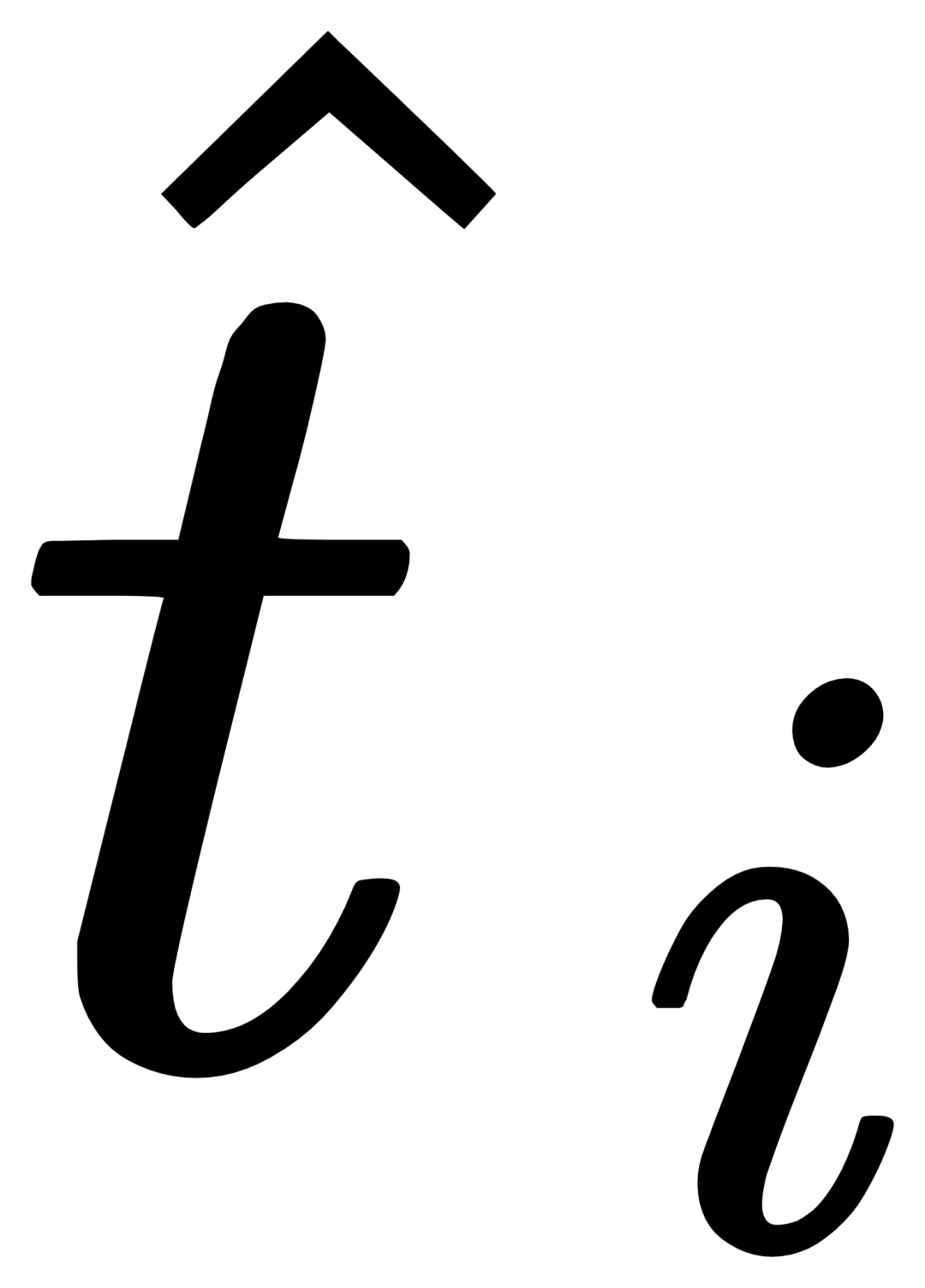

如图1所示,作者在已有冻结的文本查询检测大模型的文本编码器端逐层插入了门控感知模块(GCP),GCP的工作模式可以用下面公式简洁地表示:

对于第i个类别,输入视觉示例Vi,其首先和目标图像I进行交叉注意力(X-MHA)得到

以增广其表示能力,而后每个类别文本ti会和对应类别的视觉示例

进行交叉注意力得到

,之后通过一个门控模块gate将原始文本ti和视觉增广后文本

融合,得到当前层的输出

。这样的简单设计遵循了三点原则:(1)类别可扩展性;(2)语义补全性;(3)抗遗忘性,具体讨论可见原文。

1.3 MQ-Det高效训练策略

基于冻结语言查询检测器的调制训练

由于目前文本查询的预训练检测大模型本身就具备较好的泛化性,论文作者认为,只需要在原先文本特征基础上用视觉细节进行轻微地调整即可。

在文章中也有具体的实验论证发现,打开原始预训练模型参数后进行微调很容易带来灾难性遗忘的问题,反而失去了开放世界检测的能力。

由此,MQ-Det在冻结文本查询的预训练检测器基础上,仅调制训练插入的GCP模块,就可以高效地将视觉信息插入到现有文本查询的检测器中。

在论文中,作者分别将MQ-Det的结构设计和训练技术应用于目前的SOTA模型GLIP和GroundingDINO ,来验证方法的通用性。

以视觉为条件的掩码语言预测训练策略

作者还提出了一种视觉为条件的掩码语言预测训练策略,来解决冻结预训练模型带来的学习惰性的问题。

所谓学习惰性,即指检测器在训练过程中倾向于保持原始文本查询的特征,从而忽视新加入的视觉查询特征。

免责声明:数字资产交易涉及重大风险,本资料不应作为投资决策依据,亦不应被解释为从事投资交易的建议。请确保充分了解所涉及的风险并谨慎投资。OKEx学院仅提供信息参考,不构成任何投资建议,用户一切投资行为与本站无关。

和全球数字资产投资者交流讨论

扫码加入OKEx社群

industry-frontier